Los Modelos de Difusión son Motores de Juegos en Tiempo Real

Autores: Dani Valevski (Google Research), Yaniv Leviathan (Google Research), Moab Arar (Universidad de Tel Aviv), Shlomi Fruchter (Google DeepMind)

Enlace a ArXiv: https://arxiv.org/abs/2408.14837

Sitio web del proyecto: https://gamengen.github.io

Resumen

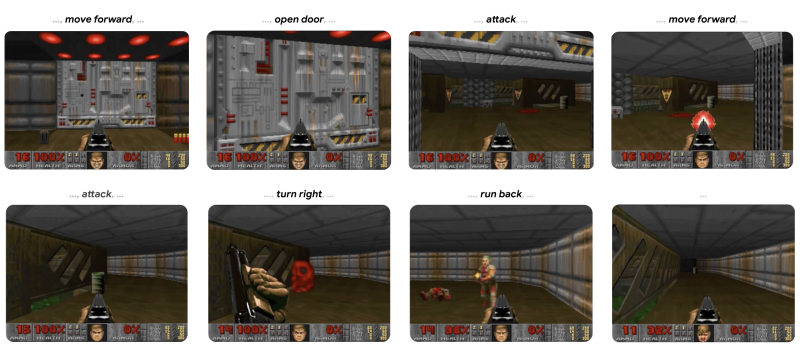

Presentamos GameNGen, el primer motor de juegos impulsado completamente por un modelo neuronal que permite la interacción en tiempo real con un entorno complejo a lo largo de trayectorias prolongadas con alta calidad. GameNGen puede simular interactivamente el juego clásico DOOM a más de 20 fotogramas por segundo en una sola TPU. La predicción del siguiente fotograma alcanza un PSNR de 29,4, comparable a la compresión JPEG con pérdidas. Los evaluadores humanos son solo ligeramente mejores que el azar al distinguir clips cortos del juego de clips de la simulación. GameNGen se entrena en dos fases: (1) un agente de aprendizaje por refuerzo (RL) aprende a jugar y se registran las sesiones de entrenamiento, y (2) se entrena un modelo de difusión para producir el siguiente fotograma, condicionado a la secuencia de fotogramas y acciones anteriores. Las mejoras de condicionamiento permiten una generación autorregresiva estable a lo largo de trayectorias prolongadas.

Visite https://gamengen.github.io para ver vídeos de demostración.

1 Introducción

Los juegos de computadora son sistemas de software creados manualmente centrados en el siguiente bucle de juego: (1) recopilar las entradas del usuario, (2) actualizar el estado del juego y (3) renderizarlo en píxeles en la pantalla. Este bucle de juego, que se ejecuta a altas velocidades de fotogramas, crea la ilusión de un mundo virtual interactivo para el jugador. Estos bucles de juego clásicamente se ejecutan en computadoras estándar, y aunque ha habido muchos intentos sorprendentes de ejecutar juegos en hardware personalizado (por ejemplo, el icónico juego DOOM se ha ejecutado en electrodomésticos de cocina como una tostadora y un microondas, una cinta de correr, una cámara, un iPod, y dentro del juego de Minecraft, por nombrar solo algunos ejemplos - Ver https://www.reddit.com/r/itrunsdoom/), en todos estos casos, el hardware sigue emulando el software de juego escrito manualmente tal cual. Además, aunque existen motores de juego muy diferentes, las actualizaciones del estado del juego y la lógica de renderizado en todos están compuestas por un conjunto de reglas manuales, programadas o configuradas a mano.

En los últimos años, los modelos generativos han logrado avances significativos en la producción de imágenes y videos condicionados a entradas multimodales, como texto o imágenes. A la vanguardia de esta tendencia, los modelos de difusión se han convertido en el estándar de facto en la generación de medios (es decir, no lingüísticos), con trabajos como Dall-E (Ramesh et al., 2022), Stable Diffusion (Rombach et al., 2022) y Sora (Brooks et al., 2024). A primera vista, la simulación de los mundos interactivos de los videojuegos puede parecer similar a la generación de videos. Sin embargo, la simulación de mundos "interactivos" es más que una simple generación de video rápida. La necesidad de condicionar un flujo de acciones de entrada que solo está disponible durante la generación rompe algunos supuestos de las arquitecturas de los modelos de difusión existentes. En particular, requiere generar fotogramas de forma autorregresiva, lo que tiende a ser inestable y conduce a la divergencia de muestreo (véase la sección 3.2.1).

Varios trabajos importantes (Ha & Schmidhuber, 2018; Kim et al., 2020; Bruce et al., 2024) (véase la Sección 6) simulan videojuegos interactivos con modelos neuronales. Sin embargo, la mayoría de estos enfoques están limitados en cuanto a la complejidad de los juegos simulados, la velocidad de simulación, la estabilidad a lo largo de largos períodos de tiempo o la calidad visual (véase la Figura 2). Por lo tanto, es natural preguntarse:

¿Puede un modelo neuronal ejecutarse en tiempo real para simular un juego complejo con alta calidad?

En este trabajo, demostramos que la respuesta es afirmativa. En concreto, mostramos que un videojuego complejo, el emblemático juego DOOM, puede ejecutarse en una red neuronal (una versión aumentada de la Stable Diffusion v1.4 abierta (Rombach et al., 2022)), en tiempo real, logrando una calidad visual comparable a la del juego original. Aunque no es una simulación exacta, el modelo neuronal es capaz de realizar actualizaciones complejas del estado del juego, como contabilizar la salud y la munición, atacar enemigos, dañar objetos, abrir puertas y mantener el estado del juego a lo largo de trayectorias largas.

GameNGen responde a una de las preguntas importantes en el camino hacia un nuevo paradigma para los motores de juegos, uno en el que los juegos se generen automáticamente, de forma similar a cómo se generan imágenes y videos mediante modelos neuronales en los últimos años. Quedan por resolver cuestiones clave, como cómo se entrenarían estos motores de juegos neuronales y cómo se crearían eficazmente los juegos en primer lugar, incluyendo la mejor manera de aprovechar las aportaciones humanas. No obstante, estamos muy emocionados por las posibilidades de este nuevo paradigma.

2 Simulación Interactiva del Mundo

Un Entorno Interactivo consiste en un espacio de estados latentes , un espacio de proyecciones parciales del espacio latente , una función de proyección parcial , un conjunto de acciones , y una función de probabilidad de transición tal que .

Por ejemplo, en el caso del juego DOOM, es el contenido de la memoria dinámica del programa, son los píxeles renderizados de la pantalla, es la lógica de renderizado del juego, es el conjunto de pulsaciones de teclas y movimientos del ratón, y es la lógica del programa dada la entrada del jugador (incluyendo cualquier potencial no determinismo).

Dado un entorno interactivo de entrada , y un estado inicial , una simulación de mundo interactivo es una función de distribución de simulación . Dada una métrica de distancia entre observaciones , una política, es decir, una distribución sobre las acciones del agente dadas las acciones pasadas y las observaciones , una distribución sobre los estados iniciales, y una distribución sobre la duración de los episodios, el objetivo de la simulación de mundo interactivo consiste en minimizar donde , , y son observaciones muestreadas del entorno y de la simulación al aplicar la política del agente . Es importante destacar que las acciones de condicionamiento para estas muestras siempre se obtienen mediante la interacción del agente con el entorno , mientras que las observaciones de condicionamiento pueden obtenerse de (el objetivo de forzamiento por el maestro) o de la simulación (el objetivo autorregresivo).

Siempre entrenamos nuestro modelo generativo con el objetivo de forzamiento por el maestro. Dada una función de distribución de simulación , el entorno puede simularse mediante el muestreo de observaciones de manera autorregresiva.

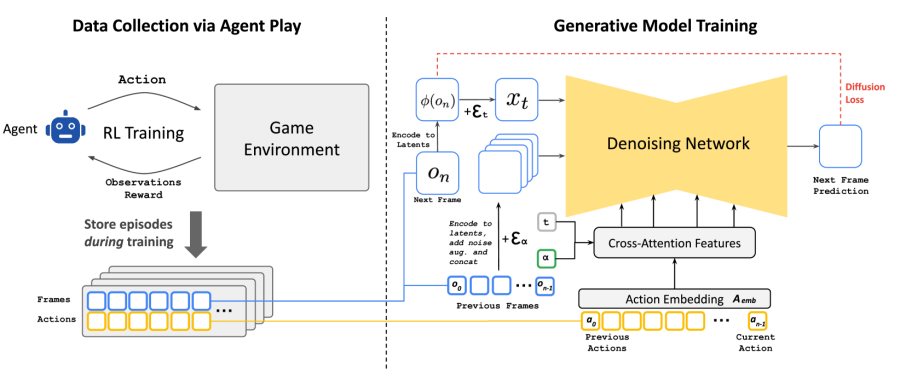

3 GameNGen

GameNGen (pronunciado «motor de juego») es un modelo generativo de difusión que aprende a simular el juego bajo los parámetros de la sección 2. Para recopilar datos de entrenamiento para este modelo, utilizando el objetivo de forzamiento por el maestro, primero entrenamos un modelo separado para interactuar con el entorno. Los dos modelos (agente y generativo) se entrenan en secuencia. La totalidad del corpus de acciones y observaciones del agente durante el entrenamiento se mantiene y se convierte en el conjunto de datos de entrenamiento para el modelo generativo en una segunda etapa. Véase la figura 3.

3.1 Recolección de Datos Mediante el Juego del Agente

Nuestro objetivo final es que los jugadores humanos interactúen con nuestra simulación. Para ello, la política como en la sección 2 es la del juego humano. Dado que no podemos tomar muestras de eso directamente a gran escala, comenzamos por aproximarlo enseñando a un agente automático a jugar. A diferencia de una configuración típica de RL que intenta maximizar la puntuación del juego, nuestro objetivo es generar datos de entrenamiento que se asemejen al juego humano, o que al menos contengan suficientes ejemplos diversos en una variedad de escenarios, para maximizar la eficiencia de los datos de entrenamiento. Para ello, diseñamos una función de recompensa sencilla, que es la única parte de nuestro método que es específica del entorno (véase el apéndice A.3).

Registramos las trayectorias de entrenamiento del agente durante todo el proceso de formación, lo que incluye diferentes niveles de habilidad de juego. Este conjunto de trayectorias registradas constituye nuestro conjunto de datos , utilizado para entrenar el modelo generativo (véase la sección 3.2).

3.2 Entrenamiento del Modelo Generativo de Difusión

Ahora entrenamos un modelo generativo de difusión condicionado a las trayectorias del agente (acciones y observaciones) recopiladas durante la etapa anterior.

Reutilizamos un modelo de difusión de texto a imagen preentrenado, Stable Diffusion v1.4 (Rombach et al., 2022). Condicionamos el modelo en trayectorias , es decir, en una secuencia de acciones previas y observaciones (fotogramas) , y eliminamos todo condicionamiento textual. Específicamente, para condicionar en las acciones, simplemente aprendemos una incrustación de cada acción (por ejemplo, una pulsación de tecla específica) en un único token y sustituimos la atención cruzada del texto en esta secuencia de acciones codificadas. Para condicionar en las observaciones (es decir, los fotogramas anteriores), las codificamos en el espacio latente utilizando el autocodificador y las concatenamos en la dimensión de los canales latentes a los latentes ruidosos (véase la figura 3). También experimentamos condicionando estas observaciones anteriores mediante atención cruzada, pero no observamos mejoras significativas.

Entrenamos el modelo para minimizar la pérdida de difusión usando la parametrización de velocidad (Salimans & Ho, 2022b):

(1)

donde , , , , , , y es la salida de la predicción v del modelo . El cronograma de ruido es lineal, de forma similar a Rombach et al. (2022).

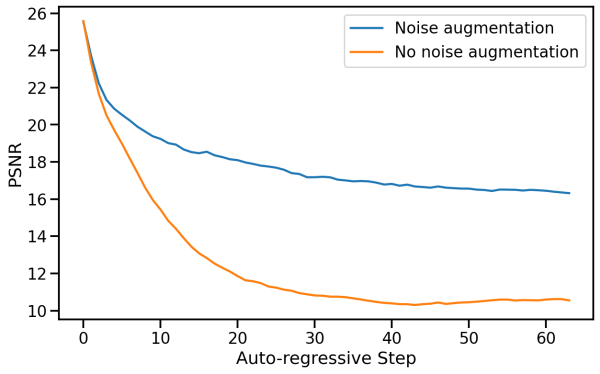

3.2.1 Mitigación de la Deriva Autorregresiva Utilizando la Augmentación de Ruido

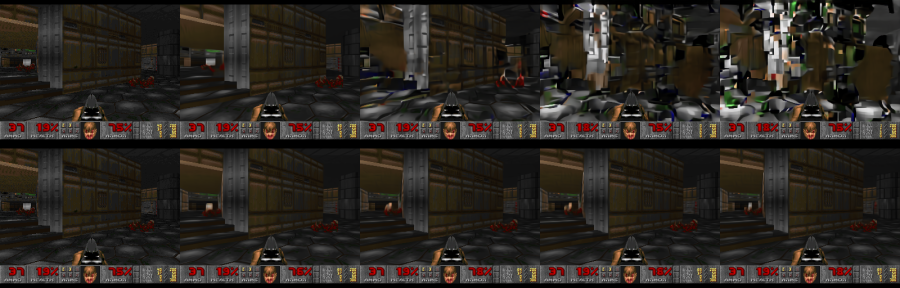

El cambio de dominio entre el entrenamiento con el objetivo de forzado por el maestro y el muestreo autorregresivo lleva a la acumulación de errores y a una rápida degradación de la calidad de la muestra, como se demuestra en la figura 4. Para evitar esta divergencia debida a la aplicación autorregresiva del modelo, corrompemos los fotogramas de contexto añadiendo una cantidad variable de ruido gaussiano a los fotogramas codificados durante el tiempo de entrenamiento, mientras proporcionamos el nivel de ruido como entrada al modelo, siguiendo a Ho et al. (2021). Para ello, muestreamos un nivel de ruido de manera uniforme hasta un valor máximo, lo discretizamos y aprendemos una representación para cada intervalo (véase la figura 3). Esto permite a la red corregir la información muestreada en fotogramas anteriores, y es fundamental para preservar la calidad del fotograma a lo largo del tiempo. Durante la inferencia, el nivel de ruido añadido puede ser controlado para maximizar la calidad, aunque comprobamos que incluso sin ruido añadido los resultados mejoran significativamente. Evaluamos el impacto de este método en la sección 5.2.2.

3.2.2 Ajuste Fino del Decodificador Latente

El autocodificador preentrenado de Stable Diffusion v1.4, que comprime parches de 8x8 píxeles en 4 canales latentes, produce artefactos significativos al predecir los fotogramas del juego, lo que afecta a los pequeños detalles y, en particular, a la barra inferior del HUD («heads-up display»). Para aprovechar el conocimiento preentrenado y mejorar al mismo tiempo la calidad de la imagen, entrenamos solo el decodificador del autocodificador latente utilizando una pérdida MSE calculada contra los píxeles del fotograma objetivo. Podría ser posible mejorar aún más la calidad utilizando una pérdida perceptual como LPIPS (Zhang et al. (2018)), lo cual dejamos para trabajos futuros. Es importante señalar que este proceso de ajuste fino tiene lugar de forma completamente independiente al ajuste fino de la U-Net, y que, en particular, la generación autorregresiva no se ve afectada por él (solo condicionamos autorregresivamente los latentes, no los píxeles). El apéndice A.2 muestra ejemplos de generaciones con y sin ajuste fino del autocodificador.

3.3 Inferencia

3.3.1 Configuración

Utilizamos el muestreo DDIM (Song et al., 2022). Empleamos la Guía Sin Clasificador (Ho & Salimans, 2022) solo para la condición de observaciones pasadas . No encontramos guía para la condición de acciones pasadas que mejorara la calidad. La ponderación que utilizamos es relativamente pequeña (1.5), ya que ponderaciones mayores crean artefactos que aumentan debido a nuestro muestreo autorregresivo.

También experimentamos con la generación de 4 muestras en paralelo y la combinación de los resultados, con la esperanza de evitar que se aceptaran predicciones extremas poco frecuentes y reducir la acumulación de errores. Probamos tanto promediar las muestras como elegir la muestra más cercana a la mediana. El promediado funcionó ligeramente peor que un solo fotograma, y elegir la más cercana a la mediana funcionó sólo marginalmente mejor. Dado que ambos aumentan los requisitos de hardware a 4 TPUs, optamos por no utilizarlos, pero señalamos que podría ser un área interesante para trabajos futuros.

3.3.2 Pasos de Muestreo del Denoizador

Durante la inferencia, necesitamos ejecutar tanto el denoizador U-Net (durante una serie de pasos) como el autocodificador. En nuestra configuración de hardware (un TPU-v5), tanto un único paso del denoizador como una evaluación del autocodificador tardan 10 ms. Si ejecutáramos nuestro modelo con un único paso del denoizador, la latencia total mínima posible en nuestra configuración sería de 20 ms por fotograma, o 50 fotogramas por segundo. Normalmente, los modelos generativos de difusión, como Stable Diffusion, no producen resultados de alta calidad con un solo paso de denoización, y en su lugar requieren docenas de pasos de muestreo para generar una imagen de alta calidad. Sorprendentemente, descubrimos que podemos simular DOOM de forma robusta, con solo 4 pasos de muestreo DDIM (Song et al., 2020). De hecho, no observamos ninguna degradación en la calidad de la simulación cuando utilizamos 4 pasos de muestreo frente a 20 pasos o más (véase el apéndice A.4).

El uso de solo 4 pasos de denoising resulta en un costo total de U-Net de 40 ms (y un costo total de inferencia de 50 ms, incluyendo el auto-codificador) o 20 fotogramas por segundo. Nuestra hipótesis es que el impacto insignificante en la calidad con pocos pasos en nuestro caso se debe a una combinación de: (1) un espacio de imágenes restringido, y (2) un fuerte condicionamiento por los fotogramas anteriores.

Dado que observamos degradación al utilizar un solo paso de muestreo, también experimentamos con la destilación de modelos de manera similar a (Yin et al., 2024; Wang et al., 2023) en el entorno de un solo paso. La destilación ayuda sustancialmente en este caso (permitiéndonos alcanzar los 50 FPS como se mencionó antes), pero aún conlleva cierto coste para la calidad de la simulación, por lo que optamos por utilizar la versión de 4 pasos sin destilación para nuestro método (véase el Apéndice A.4). Este es un área interesante para futuras investigaciones.

Observamos que es sencillo aumentar aún más la tasa de generación de imágenes de manera sustancial al paralelizar la generación de varios fotogramas en hardware adicional, similar a la técnica clásica de Nvidia SLI Alternate Frame Rendering (AFR). Al igual que con AFR, la tasa real de simulación no aumentaría ni se reduciría el retardo de entrada.

4 Configuración Experimental

4.1 Entrenamiento del Agente

El modelo de agente se entrena utilizando PPO (Schulman et al., 2017), con una CNN simple como red de características, siguiendo a Mnih et al. (2015). Se entrena en CPU utilizando la infraestructura de Stable Baselines 3 (Raffin et al., 2021). Al agente se le proporcionan versiones reducidas de las imágenes de los fotogramas y del mapa del juego, cada una con una resolución de 160x120. El agente también tiene acceso a las últimas 32 acciones que realizó. La red de características calcula una representación de tamaño 512 para cada imagen. El actor y el crítico de PPO son cabezas MLP de 2 capas sobre una concatenación de las salidas de la red de características de la imagen y la secuencia de acciones pasadas. Entrenamos al agente para que juegue utilizando el entorno de Vizdoom (Wydmuch et al., 2019). Ejecutamos 8 juegos en paralelo, cada uno con un tamaño de búfer de repetición de 512, un factor de descuento , y un coeficiente de entropía de . En cada iteración, la red se entrena utilizando un tamaño de lote de 64 durante 10 épocas, con una tasa de aprendizaje de 1e-4. Realizamos un total de 10 millones de pasos de entorno.

4.2 Entrenamiento del Modelo Generativo

Entrenamos todos los modelos de simulación a partir de un punto de control preentrenado de Stable Diffusion 1.4, descongelando todos los parámetros de U-Net. Utilizamos un tamaño de lote de 128 y una tasa de aprendizaje constante de 2e-5, con el optimizador Adafactor sin decaimiento de peso (Shazeer & Stern, 2018) y recorte de gradiente de 1,0. Cambiamos la parametrización de la pérdida de difusión para que sea predicción v (Salimans & Ho 2022a). La condición de marcos de contexto se elimina con probabilidad 0,1 para permitir CFG durante la inferencia. Entrenamos utilizando 128 dispositivos TPU-v5e con paralelización de datos. A menos que se indique lo contrario, todos los resultados del documento son tras 700.000 pasos de entrenamiento. Para la augmentación de ruido (Sección 3.2.1), utilizamos un nivel de ruido máximo de 0,7, con 10 cubos de incrustación. Utilizamos un tamaño de lote de 2.048 para optimizar el decodificador latente; los demás parámetros de entrenamiento son idénticos a los del denoizador. Para los datos de entrenamiento, utilizamos todas las trayectorias jugadas por el agente durante el entrenamiento de RL, así como los datos de evaluación durante el entrenamiento, a menos que se mencione lo contrario. En total, generamos 900M de fotogramas para el entrenamiento. Todos los fotogramas (durante el entrenamiento, la inferencia y el condicionamiento) tienen una resolución de 320x240 con un relleno de 320x256. Utilizamos una longitud de contexto de 64 (es decir, el modelo recibe sus propias 64 últimas predicciones, así como las 64 últimas acciones).

5 Resultados

5.1 Calidad de la simulación

En general, nuestro método logra una calidad de simulación comparable a la del juego original en trayectorias largas, en términos de calidad de imagen. Para trayectorias cortas, los evaluadores humanos son apenas un poco mejores que el azar al distinguir entre los clips de la simulación y el juego real.

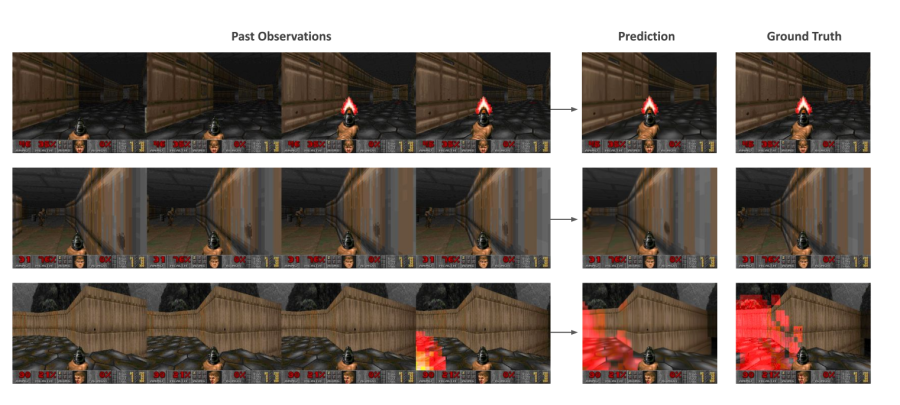

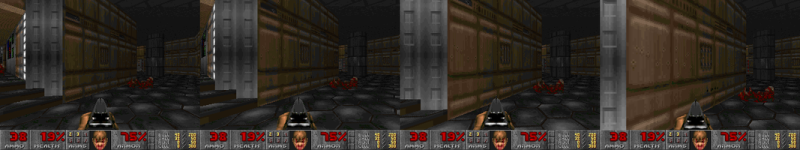

Calidad de imagen. Medimos LPIPS (Zhang et al., 2018) y PSNR utilizando la configuración de "teacher forcing" descrita en la sección 2, donde seleccionamos un estado inicial y predecimos un solo fotograma basado en una trayectoria de observaciones pasadas de referencia. Al evaluar sobre una muestra aleatoria de 2048 trayectorias tomadas en 5 niveles diferentes, nuestro modelo alcanza un PSNR de y un LPIPS de . El valor de PSNR es similar al de la compresión JPEG con pérdidas con ajustes de calidad de 20-30 (Petric & Milinkovic, 2018). La figura 5 muestra ejemplos de predicciones del modelo y las correspondientes muestras de referencia.

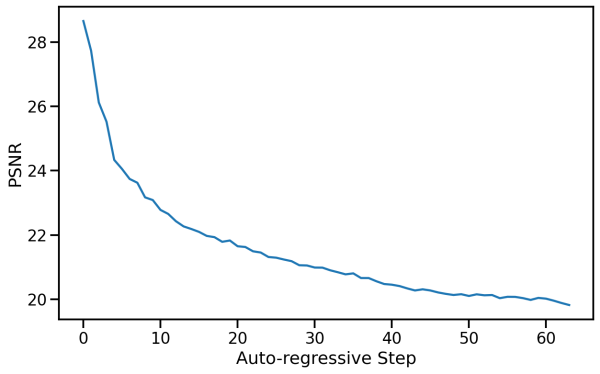

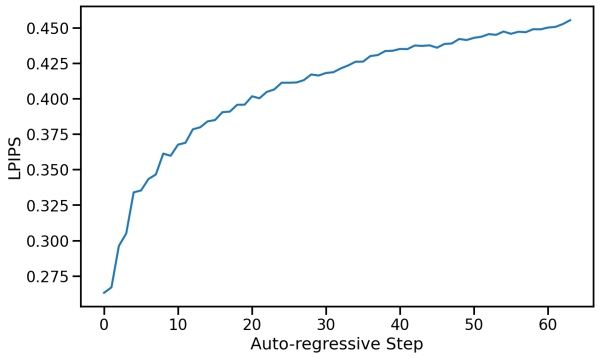

Calidad del vídeo. Utilizamos la configuración autorregresiva descrita en la sección 2, en la que muestreamos iterativamente los fotogramas siguiendo las secuencias de acciones definidas por la trayectoria del ground truth, mientras condicionamos el modelo a sus propias predicciones pasadas. Cuando se muestrean autorregresivamente, las trayectorias predichas y las del ground truth suelen divergir después de unos pocos pasos, principalmente debido a la acumulación de pequeñas diferencias en las velocidades de movimiento entre los fotogramas de cada trayectoria. Por ese motivo, los valores de PSNR y LPIPS por fotograma disminuyen y aumentan gradualmente, respectivamente, como puede verse en la figura 6. La trayectoria predicha sigue siendo similar a la del juego real en términos de contenido y calidad de imagen, pero las métricas por fotograma son limitadas en su capacidad para captar esto (véase el apéndice A.1 para ver muestras de trayectorias generadas autorregresivamente).

Por lo tanto, medimos la FVD (Unterthiner et al., 2019) calculada sobre un conjunto de 512 trayectorias seleccionadas aleatoriamente, midiendo la distancia entre las distribuciones de trayectorias predichas y las de ground truth, para simulaciones con una duración de 16 fotogramas (0,8 segundos) y 32 fotogramas (1,6 segundos). Para 16 fotogramas, nuestro modelo obtiene una FVD de . Para 32 fotogramas, nuestro modelo obtiene una FVD de .

Evaluación humana. Como otra medida de la calidad de la simulación, proporcionamos a 10 evaluadores humanos 130 clips cortos seleccionados aleatoriamente (de duraciones de 1,6 segundos y 3,2 segundos) de nuestra simulación junto con el juego real. Los evaluadores debían identificar el juego real (véase la figura 14 en el apéndice A.6). Los evaluadores solo eligieron el juego real sobre la simulación en el 58% y el 60% de las veces (para los clips de 1,6 segundos y 3,2 segundos, respectivamente).

5.2 Ablación

Para evaluar la importancia de los diferentes componentes de nuestros métodos, tomamos muestras de trayectorias del conjunto de datos de evaluación y calculamos las métricas LPIPS y PSNR entre el valor real y los fotogramas predichos.

5.2.1 Longitud del Contexto

Evaluamos el impacto de cambiar el número de observaciones pasadas en el contexto de condicionamiento entrenando modelos con (recordemos que nuestro método utiliza ). Esto afecta tanto al número de fotogramas históricos como al de acciones. Entrenamos los modelos durante 200.000 pasos manteniendo congelado el decodificador y evaluamos en trayectorias de prueba de 5 niveles. Véanse los resultados en la Tabla 1. Como era de esperar, observamos que la calidad de la generación mejora con la longitud del contexto. Curiosamente, observamos que, aunque la mejora es grande al principio (por ejemplo, entre 1 y 2 fotogramas), rápidamente nos acercamos a una asíntota y seguir aumentando el tamaño del contexto sólo proporciona pequeñas mejoras en la calidad. Esto es algo sorprendente, ya que incluso con nuestra longitud de contexto máxima, el modelo sólo tiene acceso a poco más de 3 segundos de historia. En particular, observamos que gran parte del estado del juego persiste durante períodos mucho más largos (véase la Sección 7). Aunque la longitud del contexto de condicionamiento es una limitación importante, la Tabla 1 sugiere que probablemente necesitaríamos cambiar la arquitectura de nuestro modelo para soportar eficientemente contextos más largos, y emplear una mejor selección de los fotogramas pasados sobre los que condicionar, lo que dejamos para futuros trabajos.

Tabla 1: Número de fotogramas históricos. Investigamos el número de fotogramas históricos utilizados como contexto empleando 8912 ejemplos del conjunto de pruebas de 5 niveles. Un mayor número de fotogramas generalmente mejora tanto las métricas PSNR como LPIPS.

| Longitud del contexto histórico | PSNR | LPIPS |

|---|---|---|

| 64 | ||

| 32 | ||

| 16 | ||

| 8 | ||

| 4 | ||

| 2 | ||

| 1 |

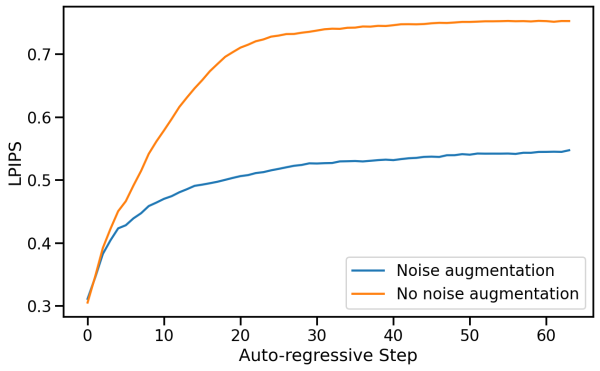

5.2.2 Augmentación de Ruido

Para analizar el impacto de la augmentación de ruido, entrenamos un modelo sin ruido añadido. Evaluamos tanto nuestro modelo estándar con augmentación de ruido como el modelo sin ruido añadido (después de 200.000 pasos de entrenamiento) autorregresivamente y calculamos las métricas PSNR y LPIPS entre los fotogramas predichos y la verdad sobre el terreno en un conjunto aleatorio de 512 trayectorias. Reportamos los valores métricos promedio para cada paso autorregresivo hasta un total de 64 fotogramas en la Figura 7.

Sin la augmentación de ruido, la distancia LPIPS respecto a la verdad sobre el terreno aumenta rápidamente en comparación con nuestro modelo estándar con augmentación de ruido, mientras que el PSNR disminuye, lo que indica una divergencia de la simulación respecto a la verdad sobre el terreno.

.

.

5.2.3 Acción del Agente

Comparamos el entrenamiento sobre datos generados por el agente con el entrenamiento sobre datos generados utilizando una política aleatoria. Para la política aleatoria, muestreamos acciones siguiendo una distribución categórica uniforme que no depende de las observaciones. Comparamos los conjuntos de datos aleatorios y de agentes entrenando 2 modelos durante 700,000 pasos junto con su decodificador. Los modelos se evalúan en un conjunto de datos de 2048 trayectorias de juego humano de 5 niveles. Comparamos el primer fotograma de generación, condicionado a un contexto histórico de 64 fotogramas de verdad de terreno, así como un fotograma después de 3 segundos de generación autorregresiva.

En general, observamos que el entrenamiento del modelo en trayectorias aleatorias funciona sorprendentemente bien, pero está limitado por la capacidad de exploración de la política aleatoria. Al comparar la generación de un solo fotograma, el agente funciona solo ligeramente mejor, logrando un PSNR de 25.06 frente a 24.42 para la política aleatoria. Al comparar un fotograma después de 3 segundos de generación autorregresiva, la diferencia aumenta a 19.02 frente a 16.84. Al interactuar manualmente con el modelo, observamos que algunas áreas son muy fáciles para ambos, otras muy difíciles para ambos, y en algunas, el agente se desempeña mucho mejor. Con esto, dividimos manualmente 456 ejemplos en 3 categorías: fácil, medio y difícil, basado en su distancia desde la posición inicial en el juego. Observamos que en los conjuntos fácil y difícil, el agente se desempeña solo ligeramente mejor que el azar, mientras que en el conjunto medio, la diferencia es mucho mayor a favor del agente, como era de esperar (véase la Tabla 2). Véase la Figura 13 en el Apéndice A.5 para un ejemplo de las puntuaciones durante una única sesión de juego humano.

Tabla 2: Rendimiento en diferentes niveles de dificultad. Comparamos el rendimiento de los modelos entrenados utilizando datos generados por el agente y generados aleatoriamente en las divisiones fácil, media y difícil del conjunto de datos. Las divisiones fácil y media tienen 112 elementos cada una, mientras que la difícil tiene 232 elementos. Las métricas se calculan para cada trayectoria en un único fotograma después de 3 segundos.

| Nivel de dificultad | Política de generación de datos | PSNR | LPIPS |

|---|---|---|---|

| Fácil | Agente | ||

| Fácil | Aleatorio | ||

| Medio | Agente | ||

| Medio | Aleatorio | ||

| Difícil | Agente | ||

| Difícil | Aleatorio |

6 Trabajos Relacionados

Simulación 3D interactiva

Simular procesos visuales y físicos de entornos 2D y 3D y permitir la exploración interactiva de los mismos es un campo ampliamente desarrollado en los gráficos por computadora (Akenine-Möller et al., 2018). Los motores de juego, como Unreal y Unity, son programas que procesan representaciones de la geometría de la escena y renderizan un flujo de imágenes en respuesta a las interacciones del usuario. El motor de juego es responsable de realizar un seguimiento de todo el estado del mundo, por ejemplo, la posición y el movimiento del jugador, los objetos, la animación de los personajes y la iluminación. También realiza el seguimiento de la lógica del juego, como los puntos obtenidos al cumplir los objetivos del juego. Las producciones cinematográficas y televisivas utilizan variantes del trazado de rayos (Shirley & Morley, 2008), que son demasiado lentas y requieren muchos cálculos para las aplicaciones en tiempo real. Por el contrario, los motores de juego deben mantener una frecuencia de fotogramas muy alta (normalmente, de 30 a 60 FPS), por lo que recurren a la rasterización de polígonos altamente optimizada, a menudo acelerada por GPUs. Los efectos físicos como sombras, partículas e iluminación suelen implementarse utilizando heurísticas eficientes en lugar de una simulación físicamente precisa.

Simulación Neural 3D

Los métodos neuronales para reconstruir representaciones 3D han experimentado avances significativos en los últimos años. Los NeRFs (Mildenhall et al., 2020) parametrizan campos de radiancia utilizando una red neuronal profunda que se optimiza específicamente para una escena dada a partir de un conjunto de imágenes tomadas desde diversas posiciones de cámara. Una vez entrenada, se pueden generar nuevos puntos de vista de la escena utilizando métodos de renderizado de volúmenes. Los enfoques de Gaussian Splatting (Kerbl et al., 2023) se basan en NeRFs pero representan escenas utilizando distribuciones Gaussianas 3D y métodos de rasterización adaptados, lo que permite tiempos de entrenamiento y renderizado más rápidos. Aunque demuestran resultados de reconstrucción impresionantes y una interactividad en tiempo real, estos métodos suelen limitarse a escenas estáticas.

Modelos de Difusión de Vídeo

Los modelos de difusión lograron resultados de estado del arte en la generación de texto a imagen (Saharia et al., 2022; Rombach et al., 2022; Ramesh et al., 2022; Podell et al., 2023), una línea de trabajo que también se ha aplicado a tareas de generación de texto a video (Ho et al., 2022; Blattmann et al., 2023b; a; Gupta et al., 2023; Girdhar et al., 2023; Bar-Tal et al., 2024). A pesar de los impresionantes avances en realismo, adherencia al texto y coherencia temporal, los modelos de difusión de video siguen siendo demasiado lentos para las aplicaciones en tiempo real. Nuestro trabajo amplía esta línea de trabajo y la adapta para la generación en tiempo real condicionada de forma autorregresiva en un historial de observaciones y acciones pasadas.

Simulación de Juegos y Modelos del Mundo

Varios trabajos han intentado entrenar modelos para la simulación de juegos con entradas de acciones. Yang et al. (2023) construyeron un conjunto de datos diverso de vídeos del mundo real y simulados y entrenaron un modelo de difusión para predecir un vídeo de continuación dado un segmento de vídeo anterior y una descripción textual de una acción. Menapace et al. (2021) y Bruce et al. (2024) se enfocan en el aprendizaje no supervisado de acciones a partir de vídeos. Menapace et al. (2024) convierten las indicaciones textuales en estados del juego, que posteriormente se convierten en una representación 3D mediante NeRF. A diferencia de estos trabajos, nosotros nos centramos en la "simulación interactiva jugable en tiempo real", y demostramos robustez en trayectorias de largo alcance. Aprovechamos un agente de RL para explorar el entorno del juego y crear despliegues de observaciones e interacciones para entrenar nuestro modelo de juego interactivo. Otra línea de trabajo exploró el aprendizaje de un modelo predictivo del entorno y su uso para entrenar a un agente de RL. Ha & Schmidhuber (2018) entrenaron un autocodificador variacional (Kingma & Welling, 2014) para codificar los fotogramas del juego en un vector latente y, a continuación, utilizaron una RNN para imitar el entorno de juego de VizDoom, entrenándose en rollouts aleatorios a partir de una política aleatoria (es decir, seleccionando una acción al azar). Luego, se aprendió una política de controlador jugando dentro del entorno "simulado". Hafner et al. (2020) demostraron que un agente de RL puede entrenarse íntegramente sobre episodios generados por un modelo de mundo aprendido en el espacio latente. También cercano a nuestro trabajo es Kim et al. (2020), que utilizaron una arquitectura LSTM para modelar el estado del mundo, acoplada a un decodificador convolucional para producir fotogramas de salida y entrenada conjuntamente bajo un objetivo adversarial. Aunque este enfoque parece producir resultados razonables para juegos sencillos como PacMan, tiene dificultades para simular el complejo entorno de VizDoom y produce muestras borrosas. En cambio, GameNGen es capaz de generar muestras comparables a las del juego original; véase la figura 2. Por último, simultáneamente a nuestro trabajo, Alonso et al. (2024) entrenaron un modelo de mundo de difusión para predecir la siguiente observación dado el historial de observaciones, y entrenaron iterativamente el modelo de mundo y un modelo de RL en juegos Atari.

DOOM

Cuando DOOM fue lanzado en 1993, revolucionó la industria de los videojuegos. Al introducir una tecnología innovadora de gráficos en 3D, se convirtió en la piedra angular del género de los videojuegos de disparos en primera persona, influyendo en innumerables otros juegos. DOOM ha sido objeto de estudio en numerosos trabajos de investigación. Ofrece una implementación de código abierto y una resolución nativa lo suficientemente baja como para permitir la simulación de modelos de tamaño reducido, pero lo suficientemente compleja como para ser un caso de prueba desafiante. Finalmente, los autores han pasado incontables horas de juventud con el juego, por lo que fue una elección obvia utilizarlo en este trabajo.

7 Discusión

Resumen. Presentamos GameNGen y demostramos que es posible lograr un juego de alta calidad en tiempo real a 20 fotogramas por segundo utilizando un modelo neuronal. También proporcionamos una guía para convertir un software interactivo, como un videojuego, en un modelo neuronal.

Limitaciones. GameNGen sufre de una cantidad limitada de memoria. El modelo solo tiene acceso a poco más de 3 segundos de historial, por lo que es notable que gran parte de la lógica del juego se mantenga durante horizontes temporales drásticamente más largos. Aunque parte del estado del juego se mantiene a través de los píxeles de la pantalla (por ejemplo, los recuentos de munición y salud, las armas disponibles, etc.), es probable que el modelo aprenda fuertes heurísticas que permiten generalizaciones significativas. Por ejemplo, a partir de la vista renderizada, el modelo aprende a inferir la ubicación del jugador, y a partir de los recuentos de munición y salud, el modelo podría inferir si el jugador ya ha pasado por una zona y derrotado a los enemigos que había allí. Dicho esto, es fácil crear situaciones en las que esta longitud de contexto no sea suficiente. Continuar aumentando el tamaño del contexto con nuestra arquitectura actual solo produce beneficios marginales (Sección 5.2.1), y la corta longitud del contexto del modelo sigue siendo una limitación importante. La segunda limitación importante son las diferencias que aún existen entre el comportamiento del agente y el de los jugadores humanos. Por ejemplo, nuestro agente, incluso al final del entrenamiento, todavía no explora todas las ubicaciones e interacciones del juego, lo que conduce a un comportamiento erróneo en esos casos.

Trabajo futuro. Demostramos GameNGen en el juego clásico DOOM. Sería interesante probarlo en otros juegos o, más en general, en otros sistemas de software interactivo. Observamos que nada en nuestra técnica es específico de DOOM, salvo la función de recompensa para el agente de aprendizaje por refuerzo. Tenemos previsto abordar esta cuestión en futuros trabajos. Aunque GameNGen consigue mantener el estado del juego con precisión, no es perfecto, según la discusión anterior. Podría ser necesaria una arquitectura más sofisticada para mitigar estos problemas. GameNGen tiene actualmente una capacidad limitada para aprovechar más que una cantidad mínima de memoria. Experimentar con una mayor ampliación de la memoria de forma eficaz podría ser fundamental para juegos/software más complejos. GameNGen funciona a 20 o 50 FPS22 ¡Más rápido de lo que corría el juego original DOOM en algunas de las máquinas 80386 de los autores en su momento! en una TPUv5. Sería interesante experimentar con más técnicas de optimización para conseguir que funcione a velocidades de fotogramas más altas y en hardware de consumo.

Hacia un nuevo paradigma para los videojuegos interactivos. Hoy en día, los videojuegos son programados por humanos. GameNGen es una prueba de concepto de una parte de un nuevo paradigma en el que los juegos son pesos de un modelo neuronal, no líneas de código. GameNGen demuestra que existe una arquitectura y unos pesos de modelo tales que un modelo neuronal puede ejecutar eficazmente un juego complejo (DOOM) de forma interactiva en el hardware existente. Aunque aún quedan muchas preguntas importantes, tenemos la esperanza de que este paradigma pueda tener beneficios significativos. Por ejemplo, el proceso de desarrollo de videojuegos bajo este nuevo paradigma podría ser menos costoso y más accesible, permitiendo que los juegos se desarrollen y editen mediante descripciones textuales o imágenes de ejemplo. Una pequeña parte de esta visión, como la creación de modificaciones o comportamientos novedosos para los juegos existentes, podría ser realizable a corto plazo. Por ejemplo, podríamos ser capaces de convertir un conjunto de fotogramas en un nuevo nivel jugable o crear un nuevo personaje solo basándonos en imágenes de ejemplo, sin necesidad de escribir código. Otras ventajas de este nuevo paradigma incluyen fuertes garantías sobre las velocidades de fotogramas y las huellas de memoria. Aún no hemos experimentado con estas direcciones y se requiere mucho más trabajo en este sentido, ¡pero estamos entusiasmados por intentarlo! Esperamos que este pequeño paso contribuya algún día a una mejora significativa de la experiencia de las personas con los videojuegos o, quizás de forma más general, de las interacciones cotidianas con los sistemas de software interactivos.

Agradecimientos

Nos gustaría expresar nuestro más sincero agradecimiento a Eyal Segalis, Eyal Molad, Matan Kalman, Nataniel Ruiz, Amir Hertz, Matan Cohen, Yossi Matias, Yael Pritch, Danny Lumen, Valerie Nygaard, los equipos de Theta Labs y Google Research, y a nuestras familias por sus valiosos comentarios, ideas, sugerencias y apoyo.

Contribución

- Dani Valevski: Desarrolló gran parte del código base, afinó parámetros y detalles en todo el sistema, añadió el ajuste fino del autoencoder, el entrenamiento del agente y la destilación.

- Yaniv Leviathan: Propuso el proyecto, método y arquitectura, desarrolló la implementación inicial y contribuyó de manera clave a la implementación y redacción.

- Moab Arar: Lideró la estabilización autorregresiva con aumento de ruido, realizó muchas de las ablaciones y creó el conjunto de datos de juego humano.

- Shlomi Fruchter: Propuso el proyecto, método y arquitectura, dirigió el proyecto, fue responsable de la implementación inicial usando DOOM, la redacción del manuscrito principal, las métricas de evaluación y la canalización de datos de política aleatoria.

Para correspondencia, contactar a shlomif@google.com y leviathan@google.com.

References

- Akenine-Möller et al. (2018) Tomas Akenine-Möller, Eric Haines, and Naty Hoffman. Real-Time Rendering, Fourth Edition. A. K. Peters, Ltd., USA, 4th edition, 2018. ISBN 0134997832.

- Alonso et al. (2024) Eloi Alonso, Adam Jelley, Vincent Micheli, Anssi Kanervisto, Amos Storkey, Tim Pearce, and François Fleuret. Diffusion for world modeling: Visual details matter in Atari, 2024.

- Bar-Tal et al. (2024) Omer Bar-Tal, Hila Chefer, Omer Tov, Charles Herrmann, Roni Paiss, Shiran Zada, Ariel Ephrat, Junhwa Hur, Guanghui Liu, Amit Raj, Yuanzhen Li, Michael Rubinstein, Tomer Michaeli, Oliver Wang, Deqing Sun, Tali Dekel, and Inbar Mosseri. Lumiere: A space-time diffusion model for video generation, 2024. URL: [1](https://arxiv.org/abs/2401.12945).

- Blattmann et al. (2023a) Andreas Blattmann, Tim Dockhorn, Sumith Kulal, Daniel Mendelevitch, Maciej Kilian, Dominik Lorenz, Yam Levi, Zion English, Vikram Voleti, Adam Letts, Varun Jampani, and Robin Rombach. Stable video diffusion: Scaling latent video diffusion models to large datasets, 2023a. URL: [2](https://arxiv.org/abs/2311.15127).

- Blattmann et al. (2023b) Andreas Blattmann, Robin Rombach, Huan Ling, Tim Dockhorn, Seung Wook Kim, Sanja Fidler, and Karsten Kreis. Align your latents: High-resolution video synthesis with latent diffusion models, 2023b. URL: [3](https://arxiv.org/abs/2304.08818).

- Brooks et al. (2024) Tim Brooks, Bill Peebles, Connor Holmes, Will DePue, Yufei Guo, Li Jing, David Schnurr, Joe Taylor, Troy Luhman, Eric Luhman, Clarence Ng, Ricky Wang, and Aditya Ramesh. Video generation models as world simulators, 2024. URL: [4](https://openai.com/research/video-generation-models-as-world-simulators).

- Bruce et al. (2024) Jake Bruce, Michael Dennis, Ashley Edwards, Jack Parker-Holder, Yuge Shi, Edward Hughes, Matthew Lai, Aditi Mavalankar, Richie Steigerwald, Chris Apps, Yusuf Aytar, Sarah Bechtle, Feryal Behbahani, Stephanie Chan, Nicolas Heess, Lucy Gonzalez, Simon Osindero, Sherjil Ozair, Scott Reed, Jingwei Zhang, Konrad Zolna, Jeff Clune, Nando de Freitas, Satinder Singh, and Tim Rocktäschel. Genie: Generative interactive environments, 2024. URL: [5](https://arxiv.org/abs/2402.15391).

- Girdhar et al. (2023) Rohit Girdhar, Mannat Singh, Andrew Brown, Quentin Duval, Samaneh Azadi, Sai Saketh Rambhatla, Akbar Shah, Xi Yin, Devi Parikh, and Ishan Misra. Emu video: Factorizing text-to-video generation by explicit image conditioning, 2023. URL: [6](https://arxiv.org/abs/2311.10709).

- Gupta et al. (2023) Agrim Gupta, Lijun Yu, Kihyuk Sohn, Xiuye Gu, Meera Hahn, Li Fei-Fei, Irfan Essa, Lu Jiang, and José Lezama. Photorealistic video generation with diffusion models, 2023. URL: [7](https://arxiv.org/abs/2312.06662).

- Ha & Schmidhuber (2018) David Ha and Jürgen Schmidhuber. World models, 2018.

- Hafner et al. (2020) Danijar Hafner, Timothy Lillicrap, Jimmy Ba, and Mohammad Norouzi. Dream to control: Learning behaviors by latent imagination, 2020. URL: [8](https://arxiv.org/abs/1912.01603).

- Ho & Salimans (2022) Jonathan Ho and Tim Salimans. Classifier-free diffusion guidance, 2022. URL: [9](https://arxiv.org/abs/2207.12598).

- Ho et al. (2021) Jonathan Ho, Chitwan Saharia, William Chan, David J Fleet, Mohammad Norouzi, and Tim Salimans. Cascaded diffusion models for high fidelity image generation. arXiv preprint arXiv:2106.15282, 2021.

- Ho et al. (2022) Jonathan Ho, William Chan, Chitwan Saharia, Jay Whang, Ruiqi Gao, Alexey A. Gritsenko, Diederik P. Kingma, Ben Poole, Mohammad Norouzi, David J. Fleet, and Tim Salimans. Imagen video: High definition video generation with diffusion models. ArXiv, abs/2210.02303, 2022. URL: [10](https://api.semanticscholar.org/CorpusID:252715883).

- Kerbl et al. (2023) Bernhard Kerbl, Georgios Kopanas, Thomas Leimkühler, and George Drettakis. 3d gaussian splatting for real-time radiance field rendering. ACM Transactions on Graphics, 42(4), July 2023. URL: [11](https://repo-sam.inria.fr/fungraph/3d-gaussian-splatting/).

- Kim et al. (2020) Seung Wook Kim, Yuhao Zhou, Jonah Philion, Antonio Torralba, and Sanja Fidler. Learning to Simulate Dynamic Environments with GameGAN. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Jun. 2020.

- Kingma & Welling (2014) Diederik P. Kingma and Max Welling. Auto-Encoding Variational Bayes. In 2nd International Conference on Learning Representations, ICLR 2014, Banff, AB, Canada, April 14-16, 2014, Conference Track Proceedings, 2014.

- Menapace et al. (2021) Willi Menapace, Stéphane Lathuilière, Sergey Tulyakov, Aliaksandr Siarohin, and Elisa Ricci. Playable video generation, 2021. URL: [12](https://arxiv.org/abs/2101.12195).

- Menapace et al. (2024) Willi Menapace, Aliaksandr Siarohin, Stéphane Lathuilière, Panos Achlioptas, Vladislav Golyanik, Sergey Tulyakov, and Elisa Ricci. Promptable game models: Text-guided game simulation via masked diffusion models. ACM Transactions on Graphics, 43(2):1–16, January 2024. doi: [10.1145/3635705](http://dx.doi.org/10.1145/3635705).

- Mildenhall et al. (2020) Ben Mildenhall, Pratul P. Srinivasan, Matthew Tancik, Jonathan T. Barron, Ravi Ramamoorthi, and Ren Ng. Nerf: Representing scenes as neural radiance fields for view synthesis. In ECCV, 2020.

- Mnih et al. (2015) Volodymyr Mnih, Koray Kavukcuoglu, David Silver, Andrei A. Rusu, Joel Veness, Marc G. Bellemare, Alex Graves, Martin A. Riedmiller, Andreas Kirkeby Fidjeland, Georg Ostrovski, Stig Petersen, Charlie Beattie, Amir Sadik, Ioannis Antonoglou, Helen King, Dharshan Kumaran, Daan Wierstra, Shane Legg, and Demis Hassabis. Human-level control through deep reinforcement learning. Nature, 518:529–533, 2015. URL: [13](https://api.semanticscholar.org/CorpusID:205242740).

- Petric & Milinkovic (2018) Danko Petric and Marija Milinkovic. Comparison between cs and jpeg in terms of image compression, 2018. URL: [14](https://arxiv.org/abs/1802.05114).

- Podell et al. (2023) Dustin Podell, Zion English, Kyle Lacey, Andreas Blattmann, Tim Dockhorn, Jonas Müller, Joe Penna, and Robin Rombach. Sdxl: Improving latent diffusion models for high-resolution image synthesis. arXiv preprint arXiv:2307.01952, 2023.

- Raffin et al. (2021) Antonin Raffin, Ashley Hill, Adam Gleave, Anssi Kanervisto, Maximilian Ernestus, and Noah Dormann. Stable-baselines3: Reliable reinforcement learning implementations. Journal of Machine Learning Research, 22(268):1–8, 2021. URL: [15](http://jmlr.org/papers/v22/20-1364.html).

- Ramesh et al. (2022) Aditya Ramesh, Prafulla Dhariwal, Alex Nichol, Casey Chu, and Mark Chen. Hierarchical text-conditional image generation with clip latents. arXiv preprint arXiv:2204.06125, 2022.

- Rombach et al. (2022) Robin Rombach, Andreas Blattmann, Dominik Lorenz, Patrick Esser, and Björn Ommer. High-resolution image synthesis with latent diffusion models. In Proceedings of the IEEE/CVF conference on computer vision and pattern recognition, pp. 10684–10695, 2022.

- Saharia et al. (2022) Chitwan Saharia, William Chan, Saurabh Saxena, Lala Li, Jay Whang, Emily L Denton, Kamyar Ghasemipour, Raphael Gontijo Lopes, Burcu Karagol Ayan, Tim Salimans, et al. Photorealistic text-to-image diffusion models with deep language understanding. Advances in Neural Information Processing Systems, 35:36479–36494, 2022.

- Salimans & Ho (2022a) Tim Salimans and Jonathan Ho. Progressive distillation for fast sampling of diffusion models. In The Tenth International Conference on Learning Representations, ICLR 2022, Virtual Event, April 25-29, 2022. OpenReview.net, 2022a. URL: [16](https://openreview.net/forum?id=TIdIXIpzhoI).

- Salimans & Ho (2022b) Tim Salimans and Jonathan Ho. Progressive distillation for fast sampling of diffusion models, 2022b. URL: [17](https://arxiv.org/abs/2202.00512).

- Schulman et al. (2017) John Schulman, Filip Wolski, Prafulla Dhariwal, Alec Radford, and Oleg Klimov. Proximal policy optimization algorithms. CoRR, abs/1707.06347, 2017. URL: [18](http://arxiv.org/abs/1707.06347).

- Shazeer & Stern (2018) Noam Shazeer and Mitchell Stern. Adafactor: Adaptive learning rates with sublinear memory cost. CoRR, abs/1804.04235, 2018. URL: [19](http://arxiv.org/abs/1804.04235).

- Shirley & Morley (2008) P. Shirley and R.K. Morley. Realistic Ray Tracing, Second Edition. Taylor & Francis, 2008. ISBN 9781568814612. URL: [20](https://books.google.ch/books?id=knpN6mnhJ8QC).

- Song et al. (2020) Jiaming Song, Chenlin Meng, and Stefano Ermon. Denoising diffusion implicit models. arXiv:2010.02502, October 2020. URL: [21](https://arxiv.org/abs/2010.02502).

- Song et al. (2022) Jiaming Song, Chenlin Meng, and Stefano Ermon. Denoising diffusion implicit models, 2022. URL: [22](https://arxiv.org/abs/2010.02502).

- Unterthiner et al. (2019) Thomas Unterthiner, Sjoerd van Steenkiste, Karol Kurach, Raphaël Marinier, Marcin Michalski, and Sylvain Gelly. FVD: A new metric for video generation. In Deep Generative Models for Highly Structured Data, ICLR 2019 Workshop, New Orleans, Louisiana, United States, May 6, 2019, 2019.

- Wang et al. (2023) Zhengyi Wang, Cheng Lu, Yikai Wang, Fan Bao, Chongxuan Li, Hang Su, and Jun Zhu. Prolificdreamer: High-fidelity and diverse text-to-3d generation with variational score distillation. arXiv preprint arXiv:2305.16213, 2023.

- Wydmuch et al. (2019) Marek Wydmuch, Michał Kempka, and Wojciech Jaśkowski. ViZDoom Competitions: Playing Doom from Pixels. IEEE Transactions on Games, 11(3):248–259, 2019. doi: [10.1109/TG.2018.2877047](http://dx.doi.org/10.1109/TG.2018.2877047).

- Yang et al. (2023) Mengjiao Yang, Yilun Du, Kamyar Ghasemipour, Jonathan Tompson, Dale Schuurmans, and Pieter Abbeel. Learning interactive real-world simulators. arXiv preprint arXiv:2310.06114, 2023.

- Yin et al. (2024) Tianwei Yin, Michaël Gharbi, Richard Zhang, Eli Shechtman, Frédo Durand, William T Freeman, and Taesung Park. One-step diffusion with distribution matching distillation. In CVPR, 2024.

- Zhang et al. (2018) Richard Zhang, Phillip Isola, Alexei A. Efros, Eli Shechtman, and Oliver Wang. The unreasonable effectiveness of deep features as a perceptual metric. In CVPR, 2018.

Appendix A Appendix

A.1 Samples

Figs. [8](https://arxiv.org/html/2408.14837v1#A1.F8), [9](https://arxiv.org/html/2408.14837v1#A1.F9), [10](https://arxiv.org/html/2408.14837v1#A1.F10), [11](https://arxiv.org/html/2408.14837v1#A1.F11) provide selected samples from GameNGen.