FAKTEN über den Aufbau von Retrieval-Augmented-Generation-basierten Chatbots

Autoren: Rama Akkiraju, Anbang Xu, Deepak Bora, Tan Yu, Lu An, Vishal Seth, Aaditya Shukla, Pritam Gundecha, Hridhay Mehta, Ashwin Jha, Prithvi Raj, Abhinav Balasubramanian, Murali Maram, Guru Muthusamy, Shivakesh Reddy Annepally, Sidney Knowles, Min Du, Nick Burnett, Sean Javiya, Ashok Marannan, Mamta Kumari, Surbhi Jha, Ethan Dereszenski, Anupam Chakraborty, Subhash Ranjan, Amina Terfai, Anoop Surya, Tracey Mercer, Vinodh Kumar Thanigachalam, Tamar Bar, Sanjana Krishnan, Jasmine Jaksic, Nave Algarici, Jacob Liberman, Joey Conway, Sonu Nayyar und Justin Boitano - NVIDIA - rakkiraju, anbangx, dbora@nvidia.com

ArXiv Link: https://arxiv.org/abs/2407.07858v1

Zusammenfassung

Enterprise-Chatbots, die von generativer KI angetrieben werden, tauchen schnell als die am meisten erforschten ersten Anwendungen dieser Technologie in der Industrie auf, mit dem Ziel, die Produktivität der Mitarbeiter zu steigern. Retrieval Augmented Generation (RAG), Large Language Models (LLMs), Langchain/Llamaindex-Typen von LLM-Orchestrierungs-Frameworks dienen als wichtige technologische Komponenten beim Aufbau von generativer KI-basierten Chatbots. Der Aufbau erfolgreicher Enterprise-Chatbots ist jedoch nicht einfach. Sie erfordern eine sorgfältige Entwicklung von RAG-Pipelines. Dazu gehört das Feinabstimmen semantischer Einbettungen und LLMs, das Extrahieren relevanter Dokumente aus Vektordatenbanken, das Umformulieren von Anfragen, das Neurangieren von Ergebnissen, das Entwerfen effektiver Eingabeaufforderungen, das Einhalten von Dokumentenzugriffskontrollen, das Bereitstellen prägnanter Antworten, das Einbeziehen relevanter Referenzen, das Schützen persönlicher Informationen und das Erstellen von Agenten zur Orchestrierung all dieser Aktivitäten. In diesem Papier präsentieren wir ein Framework zum Aufbau effektiver RAG-basierter Chatbots basierend auf unseren eigenen Erfahrungen beim Aufbau von drei Chatbots bei NVIDIA: Chatbots für IT- und HR-Vorteile, Unternehmensfinanzergebnisse und allgemeine Unternehmensinhalte. Unsere Beiträge in diesem Papier sind dreifach. Erstens stellen wir unser FACTS-Framework für den Aufbau von Enterprise-Grade RAG-basierten Chatbots vor, das die genannten Herausforderungen adressiert. FACTS-Mnemonik bezieht sich auf die fünf Dimensionen, die RAG-basierte Chatbots richtig machen müssen - nämlich Inhaltsaktualität (F), Architekturen (A), Kostenökonomie von LLMs (C), Tests (T) und Sicherheit (S). Zweitens präsentieren wir fünfzehn Kontrollpunkte von RAG-Pipelines und Techniken zur Optimierung der Leistung von Chatbots in jeder Phase. Schließlich präsentieren wir empirische Ergebnisse aus unseren Unternehmensdaten zu den Genauigkeits-Latenz-Abwägungen zwischen großen LLMs und kleinen LLMs. Soweit wir wissen, ist dies das erste Papier seiner Art, das einen ganzheitlichen Überblick über die Faktoren sowie Lösungen für den Aufbau sicherer Enterprise-Grade-Chatbots bietet.

1 Einführung

Chatbots werden zunehmend zu einer Erweiterung von Suchwerkzeugen in Unternehmen, um relevante Informationen zu finden. Ob es sich um HR-Vorteile, IT-Hilfe, Verkaufsanfragen oder technische Probleme handelt, Unternehmens-Chatbots sind mittlerweile unverzichtbare Produktivitätswerkzeuge. Vor der Einführung von OpenAI's Chat-GPT (2) im November 2022 verließen sich Unternehmen auf intern entwickelte Chatbots, die auf Dialogflüssen basierten. Solche Bots erforderten umfangreiche Schulungen für das Verständnis von Absichten und eine sorgfältige Orchestrierung zur Generierung von Antworten und konnten dennoch bestenfalls extraktive Antworten liefern. Diese frühen Bots, die auf Dialogmanagementsystemen in Kombination mit Informationsabruf- und Fragebeantwortungslösungen (IRQA) aufgebaut waren, waren fragil und in ihrer Leistungsfähigkeit begrenzt. Während frühere Generationen von Sprachmodellen und GPT-Modellen existierten, fehlte ihnen die Genauigkeit, Robustheit und Zuverlässigkeit, die für den breiten Unternehmenseinsatz erforderlich waren (5).

Die Veröffentlichung von Chat-GPT, das Aufkommen von Vektordatenbanken und die weit verbreitete Nutzung von Retrieval Augmented Generation (RAGs) (8) markierten den Beginn einer neuen Ära im Chatbot-Bereich. Jetzt können LLMs Benutzerabsichten mit einfachen Eingabeaufforderungen in natürlicher Sprache verstehen, wodurch die Notwendigkeit für komplexes Training von Intent-Varianten entfällt, Unternehmensinhalte kohärent synthetisieren und Chatbots mit einer Gesprächsfähigkeit jenseits der skriptgesteuerten Intent-Erkennung ausstatten. Während LLMs ihre generativen Fähigkeiten nutzen, um kohärente, faktische und logische Antworten auf Benutzeranfragen zu konstruieren, erweitern informationsabrufende (IR) Systeme, die auf Vektordatenbanken basieren, die Fähigkeit von LLMs, aktuelle Inhalte abzurufen. Tools wie LangChain (1) und Llamaindex (9) erleichtern den Chatbot-Aufbau und die Orchestrierung komplexer Workflows, einschließlich Speicher, Agenten, Eingabeaufforderungsvorlagen und Gesamtfluss. Zusammen bilden auf Vektorsuche basierende IR-Systeme, LLMs und LangChain-ähnliche Frameworks die Kernkomponenten einer RAG-Pipeline und treiben generative KI-Chatbots in der Post-Chat-GPT-Ära an.

| Chatbot | Domain | Datenquellen | Datentypen | Zugriffskontrolle | Beispielanfragen | Status |

|---|---|---|---|---|---|---|

| NVInfo Bot | Unternehmensinternes Wissen | SharePoint, GoogleDrive, Slack, Confluence, ServiceNow, Jira etc. | Docs, HTML, PDFs, Folien | Ja | Kann ich über Nacht auf den Parkplätzen des HQ parken? | Früher Zugangstest |

| NVHelp Bot | IT-Hilfe, HR-Vorteile | Wissensartikel für ITHelp, HR-Vorteilsseiten | Text, PDFs, Docs | Ja | Wie melde ich mich für den Mitarbeiteraktienkaufplan an? | Produktion |

| Scout Bot | Finanzielle Erträge | Unternehmensnachrichten, Blogs, SEC-Einreichungen, Ertragsbezogene Interviews | HTML, PDFs, Docs | Nein | Wie hoch sind die NVIDIA-Umsätze der letzten 3 Jahre? | Produktion |

Bei NVIDIA war unsere Hauptmotivation, die Produktivität unserer Mitarbeiter durch den Aufbau von Unternehmens-Chatbots zu verbessern. Unsere anfängliche Begeisterung stieß schnell auf die Realität, zahlreiche Herausforderungen zu bewältigen. Wir lernten, dass die Erstellung eines erfolgreichen Unternehmens-Chatbots, selbst in der Ära nach Chat-GPT, zwar vielversprechend, aber nicht einfach ist. Der Prozess erfordert eine sorgfältige Entwicklung von RAG-Pipelines, das Feinabstimmen von LLMs und das Entwickeln von Eingabeaufforderungen, um die Relevanz und Genauigkeit des Unternehmenswissens sicherzustellen, die Zugriffsberechtigungen für Dokumente zu respektieren, prägnante Antworten zu liefern, relevante Referenzen einzuschließen und persönliche Informationen zu schützen. All dies erfordert ein sorgfältiges Design, eine geschickte Ausführung und eine gründliche Bewertung, die viele Iterationen erfordert. Darüber hinaus ist es entscheidend, das Benutzerengagement aufrechtzuerhalten und gleichzeitig die Geschwindigkeit und Kosteneffizienz zu optimieren. Auf unserer Reise haben wir gelernt, dass es, einen virtuellen Unternehmensassistenten richtig hinzubekommen, dem Erreichen einer perfekten Symphonie gleicht, bei der jede Note Bedeutung trägt!

In diesem Artikel teilen wir unsere Erfahrungen und Strategien beim Aufbau effektiver, sicherer und kosteneffizienter Chatbots. Wir beantworten die folgenden Fragen aus der Perspektive eines Praktikers:

- Was sind die wichtigsten Herausforderungen, die bei der Erstellung und Bereitstellung von unternehmensgerechten generativen KI-basierten Chatbots zu berücksichtigen sind? Wir präsentieren unsere Erkenntnisse aus dem Versuch, frische Inhalte (F) mit flexiblen Architekturen (A) zu liefern, die kosteneffizient (C), gut getestet (T) und sicher (S) sind - (FACTS).

- Wie erreicht man benutzerakzeptable Qualitätsniveaus mit RAG-Systemen beim Erstellen von Chatbots? Wir präsentieren die fünfzehn Kontrollpunkte von RAG-Pipelines und Techniken zur Optimierung jedes Kontrollpunkts sowie der gesamten RAG-Pipeline.

2 Fallstudie

Die Content-Landschaft unseres Unternehmens umfasst sowohl autoritative als auch nicht-autoritative Inhalte. Autoritative Inhalte beinhalten IT-Hilfeartikel, HR-Ressourcen auf Plattformen wie ServiceNow und Projektdokumentationen auf Confluence, SharePoint, Google Drive und Ingenieurwerkzeuge wie NVBugs und GitHub. Von Mitarbeitern erstellte Inhalte ergänzen diese Quellen auf Plattformen wie Slack und MS Teams. In diesem Papier stellen wir drei Bots vor, die wir bei NVIDIA unter Verwendung von RAGs und LLMs entwickelt haben. Diese Bots werden im Folgenden kurz vorgestellt. Alle drei Bots basieren auf unserer hausintern entwickelten generativen KI-Chatbot-Plattform namens NVBot-Plattform. Einige der Anfragen, die unsere Bots beantworten können, sind in Tabelle 1 dargestellt.

- NVInfo Bot beantwortet Fragen zu Unternehmensinhalten (ca. 500 Millionen Dokumente mit einer Größe von ≈ 7 TB) und ergänzt die Intranetsuche. Es verwaltet verschiedene Datenformate und setzt Dokumentenzugriffskontrollen durch. Der Technologie-Stack umfasst LangChain, eine Anbieter-Vektordatenbank für die Suche und zur Verwaltung von Dokumentenzugriffskontrollen, ein LLM-Modell (mehrere LLM-Modelle können ausgewählt werden) und eine benutzerdefinierte Web-Benutzeroberfläche.

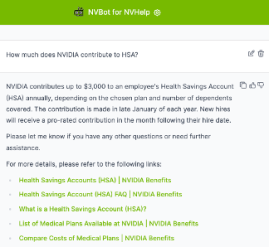

- NVHelp Bot konzentriert sich auf IT-Hilfe und HR-Vorteile (ca. 2K multimodale Dokumente, die Text, Tabellen, Bilder, PDFs und HTML-Seiten enthalten) und verwendet einen ähnlichen Technologie-Stack wie der NVInfo-Bot, jedoch mit einem kleineren Datenvolumen.

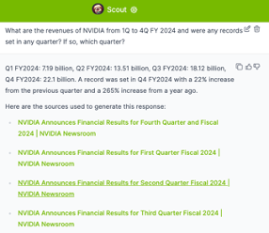

- Scout Bot bearbeitet Fragen zu finanziellen Einnahmen aus öffentlichen Quellen und verwaltet strukturierte und unstrukturierte Daten (ca. 4K multimodale Dokumente, die Text, Tabellen, PDFs und HTML-Seiten enthalten). Der Technologie-Stack umfasst eine Open-Source-Vektor-DB, LangChain, Ragas-Bewertung, auswählbare LLM-Modelle und eine benutzerdefinierte Web-UI.

Im weiteren Verlauf des Papiers stellen wir unser FACTS-Framework vor, das die Herausforderungen zusammenfasst, die bei der Entwicklung der oben genannten drei Chatbots aufgetreten sind, sowie die gewonnenen Erkenntnisse. Zunächst beginnen wir mit der Herausforderung, frische Unternehmensinhalte in jedem der Chatbots bereitzustellen.

3 Sicherstellung der Aktualität von Unternehmensdaten in LLM-gestützten Chatbots (F)

Die Sicherstellung der Aktualität von Unternehmensdaten in LLM-gestützten Chatbots stellt mehrere Herausforderungen dar. Grundmodelle, obwohl leistungsstark, reichen oft nicht aus, da ihnen domänenspezifisches und unternehmensspezifisches Wissen fehlt. Einmal trainiert, sind diese Modelle im Wesentlichen in der Zeit eingefroren und können halluzinieren, indem sie unerwünschte oder ungenaue Informationen liefern, wenn sie auf Unternehmensinhalte angewendet werden, für die sie nicht trainiert wurden.

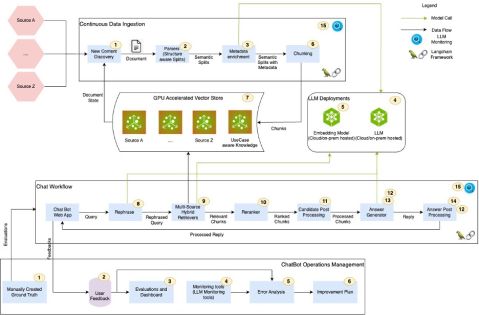

Retrieval Augmented Generation (RAG) ist ein Prozess, bei dem relevante Informationen durch semantisches Matching aus Vektordatenbanken abgerufen und dann an LLMs zur Antwortgenerierung weitergeleitet werden. In einer RAG-Pipeline arbeiten Vektordatenbanken und LLMs zusammen, um die Bereitstellung aktueller Unternehmenskenntnisse sicherzustellen. Allerdings haben RAG-Pipelines viele Kontrollpunkte, von denen jeder, wenn er nicht gut abgestimmt ist, zu geringerer Genauigkeit, Halluzinationen und irrelevanten Antworten von Chatbots führen kann. Darüber hinaus erschweren Zugriffsberechtigungen für Dokumente den Such- und Abrufprozess, was eine sorgfältige Verwaltung erfordert, um Datensicherheit und Relevanz zu gewährleisten. Außerdem erfordert multimodaler Inhalt den Einsatz multimodaler Retriever, um strukturierte, unstrukturierte und halbstrukturierte Daten, einschließlich Präsentationen, Diagrammen, Videos und Besprechungsaufzeichnungen, zu verarbeiten. Die Bewältigung dieser Herausforderungen ist entscheidend für die Aufrechterhaltung der Genauigkeit und Zuverlässigkeit von Unternehmens-Chatbots. Inspiriert von (3) identifizieren wir fünfzehn Kontrollpunkte von RAG aus unseren Fallstudien, die in Abbildung 1 visualisiert sind. Jeder Kontrollpunkt ist mit einer Nummer gekennzeichnet. Im weiteren Verlauf dieses Abschnitts präsentieren wir unsere Erkenntnisse und Erfahrungen zur Bewältigung der RAG-Kontrollpunkte.

3.1 Erkenntnisse

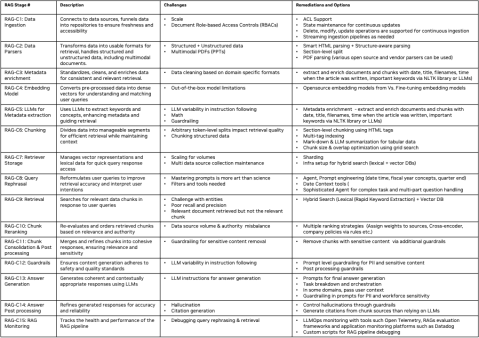

In Abbildung 4 präsentieren wir eine zusammenfassende Beschreibung der fünfzehn Kontrollpunkte der RAG-Pipelines, der Herausforderungen, die mit jedem Kontrollpunkt verbunden sind, und unserer vorgeschlagenen Ansätze zur Optimierung jedes Kontrollpunkts. Jeder Kontrollpunkt ist als RAG-C[num] und RAG-Op[num] für RAG- und RAGOps-Flüsse gekennzeichnet. Im Folgenden präsentieren wir einige wichtige Erkenntnisse und Einsichten zur Verwaltung der neuen Unternehmensinhalte.

Metadatenanreicherung, Chunking, Abfrageumformulierung, Abfragereranking: Wir haben festgestellt, dass die Phasen der Metadatenanreicherung, des Chunkings, der Abfrageumformulierung und des Abfragererankings der RAG-Pipeline den größten Einfluss auf die Qualität der Chatbot-Antworten haben. Die Qualität der LLM-Antwortgenerierung hängt stark von der Relevanz der Abfrageergebnisse ab. Diese Relevanz ist wiederum stark von der Anreicherung der Dokumentenmetadaten, dem Chunking und der Abfrageumformulierung abhängig. Wir haben auf Grid-Search basierende Auto-ML-Funktionen implementiert, um die richtigen Konfigurationen für Chunk-Token-Größen zu finden, mit verschiedenen Prompt-Variationen experimentiert und verschiedene Chunk-Reranking-Strategien erkundet, um optimale Einstellungen für jeden Bereich zu finden. Obwohl wir erhebliche Verbesserungen in der Relevanz der Abfrageergebnisse sowie in der Qualität und Genauigkeit der Antworten erzielt haben, glauben wir, dass wir noch mehr tun müssen, um die gesamte Pipeline zu optimieren.

Hybride Suche: Wir haben festgestellt, dass Vektordatenbanken nicht so gut darin sind, übereinstimmende Entitäten (z.B. Personennamen, Orte, Firmennamen usw.) zu handhaben. Die Verwendung einer Kombination aus lexikalischer Suche (z.B. Elastic Search) und Vektorsuche bietet eine bessere Relevanz bei der Suche und eine größere Abdeckung. Der Aufbau einer Infrastruktur, die hybride Suchfunktionen unterstützt und die Stärken sowohl der lexikalischen als auch der vektorbasierenden Suche kombiniert, kann die Genauigkeit und Geschwindigkeit des Suchprozesses verbessern.

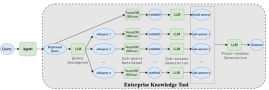

Agentische Architekturen: Fragen wie „Vergleichen Sie die Einnahmen von NVIDIA von Q1 bis Q4 des Geschäftsjahres 2024 und geben Sie einen analytischen Kommentar zu den wichtigsten Faktoren ab, die zu den Veränderungen der Einnahmen in diesem Zeitraum geführt haben“, erfordern komplexe Agenten, die in der Lage sind, Abfragen zu zerlegen und zu orchestrieren. Abbildung 2 zeigt einen Mechanismus, den wir implementiert haben, um mit solchen Fragen im Scout-Bot umzugehen. Aus unserer Erfahrung beim Bau der drei Bots haben wir erkannt, dass IR-Systeme und LLMs nicht ausreichen, um komplexe Anfragen zu beantworten. Komplexe Agenten und Multi-Agenten-Architekturen sind erforderlich, um komplexe Anfragen zu bearbeiten.

Sollten LLMs feinabgestimmt werden oder nicht? Eine wichtige Entscheidung ist, ob LLMs feinabgestimmt werden sollen, wobei das Gleichgewicht zwischen der Nutzung von Grundmodellen und domänenspezifischen Anpassungen gewahrt werden muss. Einheitslösungen passen nicht immer, wenn es um LLMs geht. Einige Anwendungsfälle funktionieren gut mit Grundmodellen, während andere Anpassungen erfordern. Bei der Betrachtung von Anpassungen stehen mehrere Optionen zur Verfügung, darunter Prompt-Engineering, P-Tuning, parameter-effizientes Fein-Tuning (PEFT) und vollständiges Fein-Tuning (FT). Fein-Tuning erfordert erhebliche Investitionen in die Datenkennzeichnung, das Training und die Evaluierungen, die jeweils zeitaufwändig und kostspielig sein können. Die Automatisierung von Test- und Qualitätsbewertungsprozessen wird entscheidend, um Effizienz und Genauigkeit bei der Anpassung von LLMs sicherzustellen. Abbildung 3 zeigt die von uns durchgeführten Bewertungen des Kompromisses zwischen Genauigkeit und Latenzzeit, bei denen wir das GPT-4-Modell von OpenAI mit einigen der Open-Source-Modelle anhand von etwa 245 Anfragen aus dem NVHelp-Bot-Bereich verglichen haben. Unsere Ergebnisse zeigen, dass das Llama3-70B-Modell in mehreren Aspekten der Antwortqualität herausragt, während es eine akzeptable Latenz beibehält.

Umgang mit multimodalen Daten: Unternehmensdaten sind multimodal. Der Umgang mit strukturierten, unstrukturierten und multimodalen Daten ist entscheidend für eine vielseitige RAG-Pipeline. Aus unserer Erfahrung, wenn die Struktur des Dokuments konsistent und im Voraus bekannt ist (wie die in EDGAR-Datenbanken für SEC-Einreichungsdaten im Bereich der finanziellen Gewinnberichte, die der Scout-Bot bearbeitete), verbessert die Implementierung von Abschnittsaufteilungen, die Verwendung von Abschnittstiteln und Unterüberschriften und deren Einbeziehung in den Kontext von Abschnitten die Relevanz der Abfrageergebnisse. Wir fanden auch Lösungen wie Unstructured.io hilfreich, die sich auf das Extrahieren und Strukturieren von Inhalten aus PDFs spezialisieren, um unstrukturierte Dokumente mit Kontext zu analysieren und in Abschnitte zu unterteilen.

RAGOps: Eine effektive Gesundheitsüberwachung von RAG-Pipelines ist unerlässlich, sobald sie eingesetzt werden. Wenn die Antwortqualität schlecht ist, ist eine gründliche Fehleranalyse erforderlich, um festzustellen, ob das Problem in der Relevanz der Abfrage oder in der Generierung der LLM-Antwort liegt. Um die Relevanz der Abfrage zu debuggen, benötigen Entwickler detaillierte Informationen darüber, welche Chunks mit ihren zugehörigen Metadaten in Vektordatenbanken gespeichert wurden, wie Abfragen umformuliert wurden, welche Chunks abgerufen wurden und wie diese Chunks bewertet wurden. Ebenso ist es wichtig, bei einer falschen LLM-Antwort das endgültige Prompt zu überprüfen, das für die Antwortgenerierung verwendet wurde. Bei Problemen mit Zitaten müssen Entwickler zu den ursprünglichen Dokumentenlinks und ihren entsprechenden Chunks zurückverfolgen. RAGOps/LLMOps und Bewertungsframeworks wie Ragas sind entscheidend, um die notwendige Automatisierung bereitzustellen, die eine schnelle Iteration während der Genauigkeitsverbesserungszyklen in RAG-Pipelines ermöglicht.

Weitere Details zu jedem Kontrollpunkt sind in Abbildung 4 dargestellt. Zusammenfassend lässt sich sagen, dass die Implementierung von RAG-Systemen für Chatbots zwar vielversprechend ist, jedoch eine sorgfältige Planung und kontinuierliche Bewertung erfordert, um eine sichere und genaue Datenabfrage zu gewährleisten.

4 Aufbau flexibler Architekturen für generative KI-Chatbots (A)

Mit dem schnellen Fortschritt in der KI Schritt zu halten, ist wie das Navigieren auf einem schnell fließenden Fluss. Jeder Aspekt, von Vektordatenbanken und Einbettungsmodellen bis hin zu LLMs, agentischen Architekturen, Low-Code/No-Code-Plattformen, RAG-Bewertungsrahmen und Prompting-Techniken, entwickelt sich rasant weiter. Gleichzeitig erkunden Abteilungen innerhalb von Unternehmen generative KI, indem sie ihre eigenen Chatbots und KI-Copiloten entwickeln.

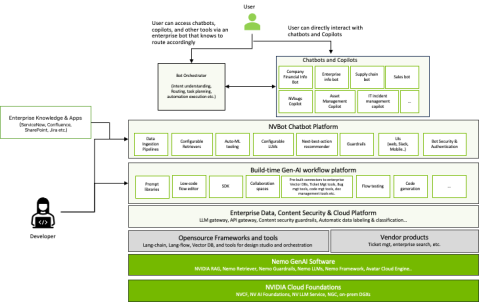

In dieser dynamischen Umgebung ist der Aufbau gemeinsamer, flexibler und anpassungsfähiger Plattformen entscheidend. Bei NVIDIA hat sich unser Chatbot-Ökosystem erheblich vergrößert, was wahrscheinlich ein Trend ist, der in vielen Unternehmen zu beobachten ist. Ausgehend von drei anfänglichen Chatbots erkannten wir die Bedeutung einer gemeinsamen Plattform, um doppelte Anstrengungen in den Bereichen Sicherheit, Schutzmaßnahmen, Authentifizierung, Eingabeaufforderungen, Benutzeroberflächen, Feedback-Mechanismen, Nutzungsberichte, Überwachung und Bewertungen zu vermeiden.

Um dies zu adressieren, haben wir die NVBot-Plattform (Abbildung 7) entwickelt, eine modulare Plattform mit einer steckbaren Architektur. Sie ermöglicht es Entwicklern, LLMs, Vektordatenbanken, Einbettungsmodelle, Agenten und RAG-Bewertungsframeworks auszuwählen, die am besten zu ihrem Anwendungsfall passen. Sie bietet auch gemeinsame Komponenten für wesentliche Funktionen wie Sicherheit, Leitplanken, Authentifizierung, Autorisierung, Benutzererfahrung und Überwachung. Darüber hinaus unterstützt die Plattform die Bürgerentwicklung, sodass mehrere Teams ihre getesteten Eingabeaufforderungen, Workflows, Leitplanken und feinabgestimmten Modelle für die kollektive Nutzung beitragen können.

Da unser Bot-Ökosystem wuchs, standen wir vor einer entscheidenden Frage: Sollten Organisationen viele domänenspezifische Bots entwickeln, einen einzigen Unternehmensbot oder einen hybriden Ansatz verfolgen? Domänenspezifische Chatbots glänzen in maßgeschneiderten Umgebungen, während unternehmensweite Chatbots als Generalisten fungieren und eine zentrale Wissensbasis für alle Mitarbeiter bieten. Durch unsere Erfahrung erkannten wir, dass es nicht notwendig ist, sich für das eine oder das andere zu entscheiden.

Neue architektonische Muster entstehen, bei denen unternehmensweite Chatbots als „Schaltzentralen“ fungieren und Anfragen an spezialisierte Bots weiterleiten, die mit domänenspezifischen Daten abgestimmt sind. Diese Multibot-Architektur ermöglicht die gleichzeitige Entwicklung spezialisierter Chatbots und bietet den Nutzern eine einheitliche Schnittstelle. Unsere NVBot-Plattform unterstützt das Nebeneinander und die Orchestrierung mehrerer Chatbots innerhalb eines Unternehmens. Die Debatte über einen einzelnen Bot oder mehrere spezialisierte Bots ist im Gange. Wir stellen uns eine Landschaft vor, in der domänenspezifische Bots mit einem zentralen Informationsbot koexistieren, unterstützt von „Copiloten“—generativen KI-Fähigkeiten, die in Arbeitsumgebungen wie Programmier-IDEs und Kollaborationstools integriert sind. Bei NVIDIA erforschen wir aktiv alle drei Chatbot-Varianten—domänenspezifisch, unternehmensweit und Copilot, da generative KI die Effizienz am Arbeitsplatz und den Zugang zu Informationen neu gestaltet.

5 Kostenökonomie von Chatbot-Einsätzen (C)

Das Verständnis der Kostenökonomie von generativen KI-basierten Chatbots umfasst mehrere kritische Faktoren. Die hohen Kosten großer und kommerzieller LLMs können untragbar sein, da sich die Ausgaben bei mehreren Anwendungsfällen erheblich summieren. Darüber hinaus häufen sich oft unsichtbare Kosten an, wenn Teams verschiedene LLMs testen, um spezifische Anforderungen zu erfüllen. Zudem erfordert die Nutzung kommerzieller LLM-Anbieter-APIs Schutzmaßnahmen, um sensible Unternehmensdaten zu sichern, indem sie Datenlecks erkennen und verhindern sowie Gateways für Audits und rechtlich zulässiges Lernen bereitstellen. Es gibt auch Abwägungen zwischen Kosten und Latenz zu berücksichtigen, da große LLMs mit langen Kontextlängen typischerweise langsamere Antwortzeiten haben, was die Gesamteffizienz beeinträchtigt.

Größere vs. kleinere Modelle: Größere kommerzielle LLMs und kleinere Open-Source-LLMs werden zunehmend für viele Anwendungsfälle praktikabel und bieten damit kostengünstige Alternativen für Unternehmen. Da Open-Source-Modelle mit größeren kommerziellen Modellen aufholen, bieten sie zunehmend eine vergleichbare Genauigkeit, wie in unserer empirischen Bewertung des NVHelp-Bots in Abbildung 3 gezeigt, und haben im Allgemeinen eine bessere Latenzleistung im Vergleich zu größeren Modellen. Darüber hinaus kann die GPU-Optimierung von Inferenzmodellen die Verarbeitungszeiten weiter beschleunigen. Open-Source-Modelle, die mit NVIDIAs Tensor RT-LLM-Inferenzbibliotheken optimiert wurden, haben beispielsweise eine schnellere Leistung gezeigt als nicht optimierte Modelle. Diese Strategien helfen, die Notwendigkeit von Kosteneffizienz mit der Aufrechterhaltung hoher Leistungs- und Sicherheitsstandards in Einklang zu bringen.

LLM Gateway: Wenn Sie eine Anbieter-LLM-API verwenden müssen, ist es besser, ein internes Unternehmens-LLM-Gateway für Audits, Abonnements und Kostenmanagement im gesamten Unternehmen zu implementieren. Die Implementierung eines internen Unternehmens-LLM-Gateways kann die Nutzung von LLM, Abonnements und die Datenverfolgung für Sicherheitsaudits optimieren. Dieses zentrale Hub vereinfacht das Management und sorgt für eine effiziente Ressourcenzuweisung. Bei NVIDIA IT haben wir ein LLM-Gateway implementiert, das die eingehenden und ausgehenden Nutzlasten zu Prüfzwecken protokolliert, und diese Daten werden mit Zugriffsberechtigungen geschützt. Unser LLM-Gateway hilft bei der Verwaltung der Abonnements und Kosten von LLM-API-Aufrufen.

Zusammenfassend lässt sich sagen, dass die Entwicklung einer hybriden und ausgewogenen LLM-Strategie entscheidend für die Kostenkontrolle und die Förderung von Innovationen ist. Dies beinhaltet die Nutzung kleinerer und angepasster LLMs zur Kostenverwaltung, während gleichzeitig eine verantwortungsvolle Erkundung mit großen LLMs über ein LLM-Gateway ermöglicht wird. Es ist wichtig, den ROI zu messen und zu überwachen, indem man LLM-Abonnements und -Kosten im Auge behält sowie die Nutzung von Gen-AI-Funktionen und Produktivitätssteigerungen bewertet. Um die Sicherheit sensibler Unternehmensdaten bei der cloudbasierten Nutzung von LLMs zu gewährleisten, müssen Schutzmaßnahmen zur Verhinderung von Datenlecks implementiert und ein LLM-Gateway für Audits und rechtlich zulässiges Lernen aufgebaut werden. Schließlich sollte man sich der Kompromisse zwischen Kosten, Genauigkeit und Latenz bewusst sein und kleinere LLMs anpassen, um die Genauigkeit größerer Modelle zu erreichen, wobei zu beachten ist, dass große LLMs mit langen Kontextlängen tendenziell längere Antwortzeiten haben.

6 Testen von RAG-basierten Chatbots (T)

Das Testen generativer KI-Lösungen kann ein langwieriger Prozess sein, da die Validierung menschlicher Antworten erforderlich ist. LLMs werden zunehmend im Rahmen des „LLM-as-a-judge“-Ansatzes eingesetzt. Es ist jedoch ratsam, Vorsicht walten zu lassen, wenn LLMs als menschliche Stellvertreter verwendet werden, da die Verwendung von LLMs als Richter zu selbst erfüllenden Prophezeiungen führen kann, die ihre inhärenten Vorurteile in Bewertungen verstärken.

- Sicherheitstests: Die Automatisierung von Sicherheitstests ist entscheidend, um die Entwicklungsgeschwindigkeit aufrechtzuerhalten, ohne die Sicherheit zu gefährden. Ein starkes Sicherheitsframework und Regressionstest-Datensätze gewährleisten, dass der Chatbot gegenüber potenziellen Bedrohungen widerstandsfähig bleibt. Wir arbeiten mit unseren internen RED-Teams im Bereich Sicherheit zusammen, um eine Reihe von Datensätzen vorzubereiten, die mit jeder größeren Iteration des Chatbots getestet werden können.

- Änderung der Eingabeaufforderung testen: Generative KI-Modelle können sehr empfindlich auf Änderungen der Eingabeaufforderung reagieren. Um die Genauigkeit zu gewährleisten, ist bei jeder Änderung der Eingabeaufforderung ein vollständiger Regressionstest erforderlich.

- Feedback-Schleifen: Die Einbeziehung gesammelten Feedbacks und des RLHF-Zyklus ist entscheidend für die kontinuierliche Verbesserung. Es ermöglicht LLM-Modellen, sowohl unsere Lösungen als auch Sprachmodelle im Laufe der Zeit zu verfeinern, wodurch der Chatbot zunehmend kompetenter wird. Wenn jedoch die gewählten Grundmodelle keine Anpassung bieten, wird es schwierig, die Modelle an menschliches Feedback anzupassen. Wenn das Feedback signifikant ist und aus vielen Bereichen stammt, könnte eine Modellanpassung eine Option sein. Derzeit haben wir begonnen, Benutzerfeedback zu sammeln, aber unsere kontinuierlichen Lernpipelines mit RLHF noch nicht aufgebaut. Werkzeuge, die dies automatisieren, sind entscheidend für das Lebenszyklusmanagement dieser Chatbots nach der Produktion.

6.1 Erkenntnisse

Plan für lange Testzyklen: Effektive Tests von RAG-basierten Chatbots erfordern die Antizipation langer Testzyklen. Beginnen Sie damit, Tests zu automatisieren und die Genauigkeitsbewertungen zu verbessern, um diese wesentliche Phase zu optimieren.

Repräsentative Ground-Truth-Datensätze erstellen: Es ist entscheidend, umfassende Ground-Truth-Datensätze zu konstruieren, die das gesamte Spektrum der angestrebten Lösungsstärken widerspiegeln. Dies stellt sicher, dass der Chatbot gegen Szenarien getestet wird, denen er im tatsächlichen Einsatz begegnen wird.

Automatisierte Bewertungen: Während der Einsatz von LLMs als Evaluatoren skalierbare Testoptionen bieten kann, sollte man nicht vergessen, dass die Qualität menschlicher Bewertungen unübertroffen ist. Automatisierte Werkzeuge sollten dort eingesetzt werden, wo es machbar ist, um menschliche Aufsicht zu ergänzen, aber nicht zu ersetzen.

Integrieren Sie menschliches Feedback und kontinuierliches Lernen: Etablieren Sie Mechanismen, die menschliches Feedback und systematische Fehleranalyse ermöglichen. Priorisieren Sie iterative Verbesserungen basierend auf diesem Feedback, um die Leistung und Anpassungsfähigkeit des Chatbots kontinuierlich zu verfeinern.

7 Sicherung von RAG-basierten Chatbots (S)

Vertrauen aufzubauen ist von entscheidender Bedeutung, wenn generative KI-Chatbots eingesetzt werden. Um Risiken zu mindern, sind Leitplanken für Halluzinationen, Toxizität, Fairness, Transparenz und Sicherheit entscheidend. Starke Grundmodelle werden zunehmend besser in diesen Leitplanken. Dennoch gibt es immer noch viele Möglichkeiten für Jailbreaks, gegnerische Angriffe und andere Sicherheitsprobleme. Abgesehen von diesen Sicherheitsrisiken sind generative KI-basierte Chatbots anfällig für derivative Risiken (unten erklärt). Da unsere Bots alle interne Unternehmens-Chatbots sind, lag unser Fokus mehr auf der Sicherheit von Unternehmensinhalten und der Absicherung sensibler Daten. Im Folgenden fassen wir unsere Erkenntnisse und Einsichten zur Sicherung von RAG-basierten Chatbots basierend auf unserer Erfahrung zusammen. Die Bewältigung dieser Herausforderungen ist unerlässlich, um die Integrität und Sicherheit von RAG-basierten Chatbots in Unternehmensumgebungen zu gewährleisten.

7.1 Erkenntnisse

Enterprise Content Access Control: Unternehmensdokumente werden durch Zugriffskontrollen geschützt, die von RAG-basierten Chatbots verlangen, dass sie während der Antwortgenerierung die Access Control Lists (ACLs) einhalten. Um diese Compliance sicherzustellen, haben wir speziell ein IR-Produkt ausgewählt, das für seine Fähigkeit bekannt ist, diese Dokumenten-ACLs effektiv zu berücksichtigen.

Derivative Risiken mit generativer KI: Chatbots könnten Antworten generieren, die den Kontext ihrer ursprünglichen Datenquellen nicht berücksichtigen, was möglicherweise zu Fehlinterpretationen führt. Darüber hinaus könnten verbesserte Suchmethoden unbeabsichtigt das Risiko erhöhen, sensible Daten offenzulegen, wenn Unternehmensinhalte nicht angemessen gesichert sind. Im Rahmen unserer NVInfo-Bot-Reise haben wir neben der Nutzung von Filter- und Klassifikationsfunktionen für sensible Daten, die von der von uns verwendeten Vektorsuchlösung bereitgestellt werden, um sensible Daten während der Abfrage automatisch herauszufiltern, auch Schutzmaßnahmen für sensible Daten implementiert.

Datenverwaltung und Inhaltssicherheit: Effizienter Wissenszugang kann das Risiko von Lecks sensibler Daten erhöhen. Daher ist es wichtig, die Datenverwaltung vor der Implementierung zu priorisieren, um unbefugten Zugriff und Datenverletzungen zu verhindern. Bei NVIDIA haben wir eine unternehmensweite Initiative zur Inhaltssicherheit gestartet, um die Klassifizierung der Dokumentensensibilität und den Ausschluss sensibler Inhalte aus Chatbots zu gewährleisten.

Unternehmensleitplanken: Die Implementierung von Leitplanken, die die Antworten generativer KI mit spezifischen Unternehmensrichtlinien und -regeln in Einklang bringen, ist entscheidend. Diese Leitplanken helfen, Risiken zu mindern, indem sie sicherstellen, dass von Chatbots generierte Inhalte den etablierten Normen und ethischen Richtlinien entsprechen und potenzielle rechtliche und rufschädigende Schäden verhindern. Im NVInfo-Bot haben wir zunächst viele Leitplanken in LLM-Eingabeaufforderungen implementiert. Später stellten wir jedoch fest, dass nicht alle LLMs diese Aufforderungen konsequent befolgen. Daher haben wir diese Leitplanken während der Vor- und Nachbearbeitung von Anfragen und Antworten mithilfe von Nemo Guardrails (13) implementiert.

8 Verwandte Arbeiten

Unsere Arbeit kann mit RAG-Papieren zu verschiedenen Themen verglichen werden, die sich mit der RAG-Qualität in allen von uns vorgestellten FACTS-Dimensionen (Frische, Architektur, Kosten, Tests und Sicherheit) befassen. Aufgrund von Platzmangel vergleichen wir unsere Arbeit mit ausgewählten Arbeiten. Barnett et. al. (3) präsentierten sieben Schwachstellen bei der Entwicklung von RAG-Systemen. In ihrer Arbeit heben sie die Herausforderungen hervor, die mit der korrekten Implementierung von Retrieval-Augmented Generation verbunden sind, indem sie ihre Erkenntnisse aus dem Bau von drei Chatbots präsentieren. Wenqi Glantz (6) erläuterte 12 RAG-Schmerzpunkte und präsentierte Lösungen. Wir haben ähnliche Herausforderungen aus erster Hand erlebt, als wir unsere Chatbots entwickelten. Allerdings diskutiert keine dieser Arbeiten die Herausforderungen bei komplexen Abfragen, Tests, dem Umgang mit Dokumentensicherheit und der Notwendigkeit flexibler Architekturen. In unserer Arbeit bauen wir nicht nur auf den oben genannten Schwach-/Schmerzpunkten von RAGs auf, sondern präsentieren auch unsere 15 Kontrollpunkte in RAG-Pipelines und bieten spezifische Lösungen für jede Phase. Außerdem erweitern wir unsere Erkenntnisse und präsentieren praktische Techniken für den Umgang mit komplexen Abfragen, Tests und Sicherheit. Wir präsentieren eine Referenzarchitektur für eine der Implementierungen agentischer Architekturen zur Handhabung komplexer Abfragen, Strategien für das Testen und Bewerten subjektiver Abfrageantworten und sensibilisieren für den Umgang mit Dokument-ACLs und Sicherheit. Darüber hinaus präsentieren wir eine Referenzarchitektur für eine flexible generative KI-basierte Chatbot-Plattform.

ChipNemo (10) liefert Beweise für die Verwendung eines domänenspezifisch angepassten Sprachmodells zur Verbesserung der Leistung von RAG bei domänenspezifischen Fragen. Sie haben das e5-small-unsupervised Modell mit 3.000 domänenspezifischen, automatisch generierten Beispielen feinabgestimmt. Wir haben versucht, das e5-large Embeddings Modell in Scout Bot feinabzustimmen. Unsere Ergebnisse zeigten keine signifikanten Verbesserungen. Derzeit sammeln wir qualitativ hochwertige, von Menschen annotierte Daten, um die Experimente zu wiederholen. Dies könnte eine wichtige Richtung für unsere zukünftige Arbeit sein. Eine weitere interessante Technik wurde von Setty et. al. (15) vorgestellt, um die Leistung von RAG mit der Hypothetical Document Embeddings (HYDE) Technik zu verbessern. HyDE verwendet ein LLM, um ein theoretisches Dokument zu generieren, wenn auf eine Anfrage geantwortet wird, und führt dann die Ähnlichkeitssuche sowohl mit der ursprünglichen Frage als auch mit der hypothetischen Antwort durch. Dies ist ein vielversprechender Ansatz, könnte jedoch die Architektur komplex machen.

Aktive Retrieval-augmented Generation (FLARE) (7) synthetisiert iterativ einen hypothetischen nächsten Satz. Wenn der generierte Satz Tokens mit niedriger Wahrscheinlichkeit enthält, würde FLARE den Satz als neue Abfrage für das Retrieval verwenden und den Satz neu generieren. Mialon et al. (12) überprüft Arbeiten zu fortgeschrittenen Methoden der augmentierten Generierung in Sprachmodellen. Self-refine (11) baut einen Agenten, um die anfängliche Antwort von RAG durch iteratives Feedback und Verfeinerung zu verbessern. Der ReAct (16) Agent wird häufig verwendet, um komplexe Anfragen rekursiv zu bearbeiten. Im Bereich der RAG-Bewertung nutzen RAGAS (4) und ARES (14) LLMs als Richter und erstellen automatische RAG-Benchmarks zur Bewertung des RAG-Systems. Zhu et al. (17) geben einen Überblick über die intensive Nutzung von LLM in einer RAG-Pipeline, einschließlich Retriever, Datengenerierung, Umschreiber und Leser. Wir glauben, dass unsere Arbeit eine einzigartige Perspektive auf den Aufbau sicherer, unternehmensgerechter Chatbots durch unser FACTS-Framework bietet.

9 Schlussfolgerungen

In diesem Artikel stellen wir unseren Ansatz zur Entwicklung effektiver RAG-basierter Chatbots vor und heben unsere Erfahrungen beim Bau von drei Chatbots bei NVIDIA hervor. Wir haben unser FACTS-Framework skizziert und die Bedeutung von Inhaltsaktualität (F), Architektur (A), Verwaltung der LLM-Kosten (C), Planung für Tests (T) und Sicherheit (S) bei der Erstellung robuster, sicherer und unternehmensgerechter Chatbots betont. Wir haben auch fünfzehn kritische Kontrollpunkte innerhalb der RAG-Pipelines identifiziert und erläutert und Strategien zur Verbesserung der Chatbot-Leistung in jeder Phase bereitgestellt. Darüber hinaus zeigt unsere empirische Analyse die Kompromisse zwischen Genauigkeit und Latenzzeit beim Vergleich großer und kleiner LLMs auf. Dieser Artikel bietet eine ganzheitliche Perspektive auf die wesentlichen Faktoren und praktischen Lösungen für den Bau sicherer und effizienter unternehmensgerechter Chatbots und leistet einen einzigartigen Beitrag zum Fachgebiet. In mehreren Bereichen ist noch mehr Arbeit erforderlich, um effektive RAG-basierte Chatbots zu entwickeln. Dazu gehört die Entwicklung agentischer Architekturen zur Bearbeitung komplexer, mehrteiliger und analytischer Anfragen; die effiziente Zusammenfassung großer Mengen häufig aktualisierter Unternehmensdaten; die Integration von Auto-ML-Funktionen zur automatischen Optimierung verschiedener RAG-Kontrollpunkte; und die Schaffung robusterer Bewertungsrahmen zur Beurteilung subjektiver Antworten und Gespräche.

Referenzen

- (1) Langchain. https://github.com/langchain-ai.

- (2) Achiam, J., Adler, S., Agarwal, S., Ahmad, L., Akkaya, I., Aleman, F. L., Almeida, D., Altenschmidt, J., Altman, S., Anadkat, S., et al. GPT-4 technical report. arXiv preprint arXiv:2303.08774 (2023).

- (3) Barnett, S., Kurniawan, S., Thudumu, S., Brannelly, Z., and Abdelrazek, M. Seven failure points when engineering a retrieval augmented generation system. arXiv preprint arXiv:2401.05856 (2024).

- (4) Es, S., James, J., Espinosa-Anke, L., and Schockaert, S. Ragas: Automated evaluation of retrieval augmented generation. arXiv preprint arXiv:2309.15217 (2023).

- (5) Galitsky, B. Developing enterprise chatbots. Springer, 2019.

- (6) Glantz, W. 12 rag pain points and proposed solutions.

- (7) Jiang, Z., Xu, F. F., Gao, L., Sun, Z., Liu, Q., Dwivedi-Yu, J., Yang, Y., Callan, J., and Neubig, G. Active retrieval augmented generation. arXiv preprint arXiv:2305.06983 (2023).

- (8) Lewis, P., Perez, E., Piktus, A., Petroni, F., Karpukhin, V., Goyal, N., Küttler, H., Lewis, M., Yih, W.-t., Rocktäschel, T., et al. Retrieval-augmented generation for knowledge-intensive nlp tasks. Advances in Neural Information Processing Systems 33 (2020), 9459–9474.

- (9) Liu, J. LlamaIndex. https://github.com/jerryjliu/llama_index(2022).

- (10) Liu, M., Ene, T.-D., Kirby, R., Cheng, C., Pinckney, N., Liang, R., Alben, J., Anand, H., Banerjee, S., Bayraktaroglu, I., et al. Chipnemo: Domain-adapted llms for chip design. arXiv preprint arXiv:2311.00176 (2023).

- (11) Madaan, A., Tandon, N., Gupta, P., Hallinan, S., Gao, L., Wiegreffe, S., Alon, U., Dziri, N., Prabhumoye, S., Yang, Y., et al. Self-refine: Iterative refinement with self-feedback. Advances in Neural Information Processing Systems 36 (2024).

- (12) Mialon, G., Dessì, R., Lomeli, M., Nalmpantis, C., Pasunuru, R., Raileanu, R., Rozière, B., Schick, T., Dwivedi-Yu, J., Celikyilmaz, A., et al. Augmented language models: a survey. arXiv preprint arXiv:2302.07842 (2023).

- (13) Rebedea, T., Dinu, R., Sreedhar, M., Parisien, C., and Cohen, J. Nemo guardrails: A toolkit for controllable and safe llm applications with programmable rails. arXiv preprint arXiv:2310.10501 (2023).

- (14) Saad-Falcon, J., Khattab, O., Potts, C., and Zaharia, M. Ares: An automated evaluation framework for retrieval-augmented generation systems. arXiv preprint arXiv:2311.09476 (2023).

- (15) Setty, S., Jijo, K., Chung, E., and Vidra, N. Improving retrieval for rag based question answering models on financial documents. arXiv preprint arXiv:2404.07221 (2024).

- (16) Yao, S., Zhao, J., Yu, D., Du, N., Shafran, I., Narasimhan, K., and Cao, Y. React: Synergizing reasoning and acting in language models. arXiv preprint arXiv:2210.03629 (2022).

- (17) Zhu, Y., Yuan, H., Wang, S., Liu, J., Liu, W., Deng, C., Dou, Z., and Wen, J.-R. Large language models for information retrieval: A survey. arXiv preprint arXiv:2308.07107 (2023).